Dobór optymalnej kamery do zadania wizyjnego

Marek Kania print

System wizyjny składa się z układu oświetlenia, obiektywu, kamery i komputera z oprogramowaniem. Elementem najbardziej zaawansowanym i krytycznym dla poprawności działania aplikacji jest kamera. Jej optymalny dobór wymaga znajomości i rozumienia funkcji modułów kamery. W artykule omówiono podstawowe cechy i funkcje implementowane w kamerach.

Przy wyborze kamery można stosować wiele kryteriów, ale w przypadku najtrudniejszych aplikacji należy skoncentrować się tylko na jednym, pozostałe parametry wybranej kamery będą miały znaczenie drugorzędne.

W artykule pominięto różnicę między kamerami ze zintegrowanym, programowalnym procesorem obrazu (kamery inteligentne, smart lub inteligentne sensory) a kamerami bez programowalnego procesora obrazu w środku. Wybór między kamerą ze zintegrowanym procesorem lub bez, to wybór konfiguracji hardware’u systemu wizyjnego, a nie dobór kamery ze względy na jej funkcje. Trzeba jednak pamiętać, że asortyment sensorów stosowanych w kamerach standardowych jest znacznie szerszy niż w kamerach zintegrowanych. Również funkcje kamer standardowych są znacznie bogatsze.

Moduły kamery

Projektując kamery, konstruktorzy często korzystają z modułów, pod względem których można dobierać kamerę. Funkcje modułów można zakwalifikować do dwóch kategorii:

- moduły, które należy dobrać ze względu na wymagania, niemające wpływu na obraz,

- moduły wpływające na obraz i realizujące wstępną obróbkę obrazu.

Do pierwszej grupy należą takie elementy kamery, jak:

- obudowa,

- mocowanie obiektywu,

- zasilanie niezależne lub zintegrowane z interfejsem wizyjnym.

Do grupy elementów wpływających na jakość obrazu należą natomiast:

- sensor,

- moduł sterowania sensorem,

- wzmacniacz obrazu i przetwornik analogowo-cyfrowy,

- procesor graficzny kamery,

- pamięć obrazów,

- interfejsy:

- wyjście wideo,

- wyjścia/wejścia sterujące.

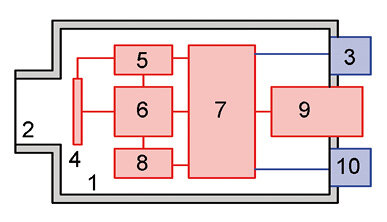

Rys. 1. Pozycje modułów funkcjonalnych kamery: 1. obudowa, 2. mocowanie obiektywu, 3. wejście zasilania, 4. sensor, 5. moduł sterujący sensorem, 6. wzmacniacz i przetwornik A/C, 7. procesor graficzny, 8. pamięć obrazów, 9. interfejs obrazowy, 10. interfejs wejść/wyjść sterujących

Moduły o znikomym wpływie na jakość obrazu

W pierwszej grupie elementów kamery, które nie wpływają w większym stopniu na jakość obrazu, są trzy moduły. Poniżej opisano ich znaczenie.

Obudowa

W wielu zadaniach małe wymiary obudowy uznawane są za zaletę, ponieważ umożliwiają minimalizację gabarytów całego systemu wizyjnego. Małe wymiary oznaczają jednak wciśnięcie w małą objętość zarówno sensora, jak i elektroniki, nagrzewającej wnętrze kamery, w tym i sensor. Każdy wzrost temperatury sensora o 7 °C powoduje podwojenie szumu sensora. Firmy dbające o jakość obrazu unikają stosowania małych obudów, jak np. 30 mm × 30 mm × 30 mm, w celu utrzymania niskich szumów sensora.

Kamera do widzenia maszynowego jest przeznaczona do pracy w trudnych warunkach przemysłowych – o zmiennej temperaturze, w zanieczyszczonym otoczeniu, przy ciągłych drganiach i doraźnych udarach. Standardowe obudowy kamer mają stopień ochrony IP30, ale są i kamery z IP65/67. Niektóre rodziny kamer dostępne są w różnych opcjach wykonania obudowy, a nawet bez niej. Mogą mieć obudowę standardową (oś obiektywu równoległa do kabli wyjściowych), obudowę kątową (oś obiektywu prostopadła do kabli wyjściowych) lub oddzielną głowicę sensorową bądź płytkę sensorową.

Mówiąc o obudowie, warto omówić zagadnienia niezwiązane funkcjonalnie z konkretnym modułem kamery, ale najbliższe obudowie, chociaż wynikające z konstrukcji całej kamery, takie jak zakres temperatury pracy oraz odporność na drgania i udary.

Zakres temperatury pracy

Największa grupa kamer jest przystosowana do pracy w temperaturze otoczenia w zakresie od 0 °C do 40 °C. Praca w wyższej temperaturze nie tylko mocno pogarsza jakość obrazu, ale i prowadzi do bardzo przyspieszonego zużycia kamery. Wśród nowych kamer standardowych dostępne są kamery z zakresem temperatury pracy od –20 °C do +65 °C. Firma JAI oferuje modele standardowe niektórych kamer iwiele wykonań opcjonalnych starszych modeli, przeznaczonych do pracy w zakresie od –40 °C do +70 °C. Niektóre, bardzo wydajne kamery (szybkie kamery 2D lub liniowe) są fabrycznie wyposażone wradiatory. Docelowo mają one zredukować szumy w obrazie.

Rys. 2. Schemat funkcjonalny kamery: 1. obudowa, 2. mocowanie obiektywu, 3.wejście zasilania, 4. sensor, 5. moduł sterujący sensorem, 6. wzmacniacz i przetwornik A/C, 7. procesor graficzny, 8. pamięć obrazów, 9. interfejs obrazowy, 10. interfejs wejść/wyjść sterujących

Odporność na drgania i udary

Mimo iż kamera do widzenia maszynowego przeznaczona jest do pracy w trudnych warunkach, większość producentów kamer nie specyfikuje odporności na drgania i udary. Firma JAI dla większości kamer deklaruje odporność na drgania z zakresu 20–200 Hz z przyspieszeniami do 10g i na udary o przyspieszeniach do 70g.

Mocowanie obiektywu

W kamerach do widzenia maszynowego stosowane są mocowania C-mount, CS-mount, F-mount, M42 i M72. Dla sensorów o przekątnej lub długości do 24 mm najpopularniejsze są mocowania C-mount, adla sensorów o przekątnej lub długości powyżej 16 mm, do 43 mm – mocowania F-mount. Większe sensory i dłuższe linie kamer liniowych wymagają zastosowania mocowań niestandardowych.

W kamerach wyższej klasy mocowanie C-mount może mieć regulację pozycji. Uwzględniając fakt, że pozycja sensora w kamerze ma tolerancję położenia i obiektyw też ma tolerancję pozycji ogniska, można się spodziewać, że przy ustawieniu ostrości obiektywu na nieskończoność, ognisko obiektywu nie pokryje się z położeniem sensora. Wówczas nie da się ustawić ostrości dla nieskończoności. Dlatego lepsze kamery mają możliwość poosiowej regulacji położenia powierzchni oporowej mocowania C-mount.

Zasilanie

Zasilanie większości kamer do widzenia maszynowego realizowane jest albo przez wtyczkę Hirose (zwykle piny 1 i 2), albo jest zintegrowane z interfejsem wizyjnym (USB, FireWire, GigE PoE, CameraLink PoCL, CoaXpress PoCXP).

W starszych kamerach napięcie zasilające wynosiło 12 V DC lub było zgodne z normą dla interfejsu wizyjnego, w którym zasilanie jest zintegrowane, np. 5 V DC dla USB 2.0.

Wiele nowszych kamer akceptuje napięcia zasilające z pewnego zakresu, np. 5–30 V DC lub 12–24 V DC. Często kamery są wyposażane w dwie opcja zasilania – przez niezależne gniazdo i przez interfejs wideo.

Moduły wpływające na jakość obrazu

Kluczowe dla poprawnego działania kamery są podzespoły, które wpływają na jakość odbieranego lub rejestrowanego obrazu.

Sensor

Sensor to najważniejszy, najbardziej skomplikowany i najbardziej zróżnicowany element kamery. Kamery dobierane są głównie ze względu na właściwy sensor. Nieoptymalny dobór innych modułów lub funkcji kamery można próbować nadrobić w programie obróbki obrazu. Złego obrazu, spowodowanego nieodpowiednim sensorem, nie da się naprawić. Braku informacji w obrazie nie uzupełni się nawet najmądrzejszym programem.

Dobierając sensor należy zwrócić uwagę na szereg cech.

Typ sensora: 2D lub liniowy

Istnieją dwie kategorie sensorów: dwuwymiarowe (2D) i liniowe (1D), jedno- lub wieloliniowe. Wybór sensora pod tym względem nie jest zadaniem trudnym.

Jeśli widoczny jest cały obiekt, pożądana rozdzielczość sensora jest dostępna lub zostanie osiągnięta przez jednoczesne użycie kilku kamer, a równomierne oświetlenie całego obiektu jest możliwe, to naturalnym wyborem jest kamera 2D. Aktualnie dostępne rozdzielczości wystarczają do większości zadań wizyjnych.

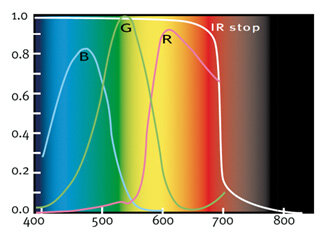

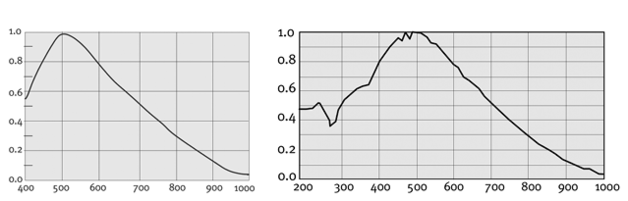

Rys. 3. Charakterystyka absorbcji widmowej sensorów kamer standardowych (po lewej) i z podwyższoną czułością w UV (po prawej)

Sensor liniowy jest najczęściej wybierany, gdy widać tylko mały fragment badanego obiektu, ale obiekt ten przemieszcza się. Przykładem może być rejestracja obrazu wstęgi materiału lub dużego arkusza. Kolejne powody użycia sensorów liniowych to możliwość uzyskania znacznie wyższej rozdzielczości obrazu niż z kamery 2D. Przykładowo, przez zeskanowanie arkusza blachy o szerokości X i długości 2X kamerą liniową o rozdzielczości 16 kpx, uzyskamy obraz zawierający 512 Mpx, nieosiągalny dla jednej kamery 2D. Kolejny powód to łatwość oświetlenia wąskiego paska obszaru patrzenia kamery liniowej, w porównaniu z potrzebą równomiernego oświetlenia dużego obszaru dla kamery 2D.

Sensory dwu- lub wieloliniowe służą do fuzji obrazów z tych linii:

- Sensory kolorowe dwu- lub trzyliniowe – dają obraz barwny RGB.

- Sensory mono dwuliniowe dają możliwość zwiększenia wysokości piksela, po zsumowaniu sygnałów sąsiadujących pikseli, lub poprawienia stosunku sygnału do szumu, po zsumowaniu sygnałów zdwóch linii, z przesunięciem o jeden takt zegarowy pomiędzy liniami. Sygnały sumują się liniowo a szumy geometrycznie.

- Sensory wieloliniowe TDI (Time Delay Integration) rejestrują jednocześnie obrazy wielu linii, a w każdym następnym takcie zegarowym sygnały pikseli przenoszone są do następnej linii, w której sumują się z sygnałem z kolejnego naświetlenia obrazu tego samego obszaru obiektu. Wielokrotne naświetlenie tego samego obszaru przesuwającego się obiektu daje zwielokrotnienie sygnału. Jest to wykorzystywane do skanowania szybko przemieszczających się lub słabo oświetlonych obiektów.

- Sensory kamer 3D to sensory 2D, z tą różnicą, że na zewnątrz kamery nie jest wyprowadzany pełen obraz 2D, a tylko przetworzona w kamerze informacja 3D. Przetwarzanie to może być realizowane w sensorze lub w układzie FPGA kamery.

Technologia CCD lub CMOS

Sensor CCD to jeden wielki krzemowy zbiornik elektronów, z naniesionymi elektrodami sterującymi ładunkami. Elektrody te, w trakcie odczytywania obrazu, przyciągają ładunki do dolnej linii pikseli, zktórej przekazywane są do przetwornika, zamieniającego zgromadzony ładunek na napięcie. Prześwietlenie jednego piksela sensora CCD powoduje, że elektrony przelewają się do sąsiednich pikseli (tzw. blooming), a przy mocnym prześwietleniu pikseli ładunek rozlewa się po pionowym kanale transferowym (efekt smear).

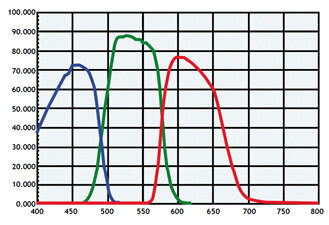

Rys. 4. Charakterystyka separacji barw przez filtry dichroiczne, stosowane w kamerach trójsensorowych (na górze) i filtrów polimerowych na sensorach kolorowych (na dole). Oba wykresy prezentują sumę działań filtrów i charakterystyki sensora. Wyraźnie mniejsze zakresy nakładania się zakresów R, G i B dają filtry dichroiczne

Sensor CMOS zbudowany jest z wielu oddzielnych fotodiod ze wzmacniaczami w każdym pikselu. Powoduje to, że prześwietlenie jednego piksela nasyca jego fotodiodę, ale nie powoduje prześwietlenia pikseli sąsiednich. Wadą tego rozwiązania jest duży rozrzut wzmocnienia wielu wzmacniaczy pikseli, co w efekcie daje duży szum w obrazie (tzw. fixed pattern noise).

Sensory CCD mają zazwyczaj większą czułość i mniejsze szumy, ale sensory CMOS mogą być szybciej odczytywane, a dowolnie zaprogramowany skan częściowy (ROI, ang. Region of Interest) daje zwiększenie szybkości odczytu takiego sensora.

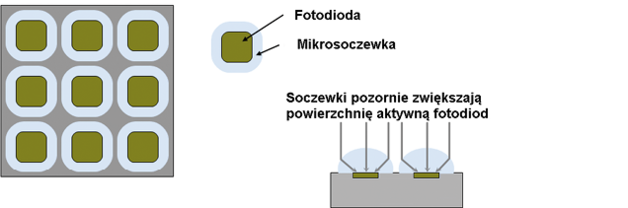

W obu typach sensorów tylko mały fragment piksela jest odkryty i pochłania światło, a reszta powierzchni zakryta jest przez elektrody sterujące lub przez lokalny wzmacniacz. W celu powiększenia obszaru absorbcji światła oba typy sensorów wyposażane są w matryce mikrosoczewek. Mikrosoczewki mają rozmiar piksela i znacznie zwiększają obszar czułości (fill factor) sensora.

Sensor CCD z bardzo cienkim podłożem, oświetlany od tyłu (backside illuminated), ma elektrody po stronie przeciwnej płatka krzemu niż powierzchnia absorbcji światła. W efekcie jego fill factor wynosi 100 proc., bez zastosowania mikrosoczewek. Sensory te to duża nadzieja dokładnych systemów pomiarów wielkości geometrycznych. Na razie stosowane są one w nielicznych kamerach, stosowanych głównie w badaniach naukowych.

Wielkość i rozdzielczość sensora, wielkość pikseli

Podstawowym kryterium selekcji kamery jest rozdzielczość sensora. Znając pole widzenia i pożądaną rozdzielczość na obiekcie, można wyliczyć pożądaną rozdzielczość sensora. W standardowych kamerach dostępne są sensory od 320 × 256 px w kamerach IR, do 6576 × 4384 px w sensorach 2D, chociaż produkowane są też sensory o wyższych rozdzielczościach, np. 10 000 × 7096 px. Cena kamery zależy głównie od wielkości sensora, a nie jego rozdzielczości. Przy doborze rozdzielczości trzeba zwrócić uwagę na wielkość piksela. Im większe piksele, tym wyższa ich czułość i łatwiejszy dobór obiektywu. Wiele tanich sensorów ma piksele o boku 2–3 µm, a tylko nieliczne obiektywy dają tak małą plamkę obrazową, aby uzyskały rozdzielczość taką, jaką ma sensor. Bez problemu można dobrać obiektyw do pikseli rzędu 7 µm. Do pikseli o boku z zakresu 3,5–5 µm trzeba stosować obiektywy 3–5 Mpx, a do najmniejszych pikseli 1,75 µm – dobrze dobrany obiektyw jest droższy niż kamera. Dlatego bardzo rozważnie należy oceniać wielkość pikseli wybranej kamery.

Dla sensorów kolorowych rozdzielczość obiektywu (lub wielkość jego plamki obrazowej) może być zbliżona do wymiaru 2 × 2 px lub 3 × 3 px (zależnie od typu interpolacji Bayera). Wielkość piksela nie jest więc krytyczna.

Popularne kamery liniowe mają od 512 px do 16 384 px w linii. Piksele mają wymiar od 3,5 µm w sensorach 16 kpx do 14 µm w wielu sensorach liniowych niższej rozdzielczości. Same sensory produkowane są też w wyższej rozdzielczości, np. 24 640 px.

W kamerach 3D aktualnie dostępne są sensory o rozdzielczości od 640 × 460 px do 4096 × 3072 px.

Zakres absorbcji spektralnej

Najpopularniejsze sensory kamer do widzenia maszynowego wykonane są z krzemu, którego widmo absorbcji spektralnej rozciąga się od pasma UV (poniżej 200 nm) do bliskiej podczerwieni (1000–1100 nm). Standardowy sensor mono ma szybkę ochronną, która tłumi zakres UV. W praktyce podaje się, że kamera absorbuje promieniowanie od około 400 nm. Sensory mono z podwyższoną czułością wzakresie UV mają szybkę nakrywkową z kwarcu, a nie ze szkła, w wyniku czego zakres fal o długości 200–400 nm nie jest tłumiony. Sensory IR mają natomiast lekko przytłumioną absorbcję zakresu widzialnego, w wyniku czego czułość w zakresie 700–1100 nm jest względnie wyższa.

Sensory kolorowe są pokryte matrycą polimerowych mikrofiltrów RGB. Natomiast kamery kolorowe trójsensorowe mają trzy sensory monochromatyczne zainstalowane za pryzmatycznym dzielnikiem obrazu z filtrami dichroicznymi. Filtry te rozdzielają widmo na składowe RGB bardziej precyzyjnie niż filtry polimerowe i są bardziej trwałe. Powoduje to, że kamera trójsensorowa daje wysoką jakość odwzorowania barw i jakość ta jest niezmienna w długim okresie pracy.

Sensory kamer do podczerwieni bliskiej i dalekiej budowane są na różnych materiałach, co daje im specyficzny zakres czułości spektralnej: SWIR 0,9–1,7 µm (materiał: InGaAs), MWIR 1–5,5 µm (materiał: InSb lub HgCdTe) i LWIR 8–14 µm (mikrobolometr).

Czułość

W praktyce w kamerach do widzenia maszynowego czułość sensora wynika głównie z względnej wielkości powierzchni światłoczułej, w stosunku do całej powierzchni piksela, czyli ze wspomnianego już współczynnika fill factor. Ponieważ część powierzchni piksela zajęta jest przez elektrody lub elektronikę piksela, toteż im większy piksel, tym relatywnie większa część optycznie aktywna i tym więcej fotonów skierowanych z obiektywu na piksel zamieni się w sygnał wyjściowy.

Podwyższanie czułości sensora uzyskuje się przez pozorne zwiększenie współczynnika fill factor, np. w wyniku zamocowania na sensorze matrycy mikrosoczewek. Zbierają one fotony z prawie całego obszaru piksela i skupiają je na powierzchni światłoczułej.

Moduł sterujący sensorem

Moduł ten steruje akwizycją obrazów i odczytem sensora. Standardowa kamera do widzenia maszynowego ma kilka trybów pracy: praca ciągła, wyzwalanie generowane z programu, wyzwalanie zewnętrzne z zaprogramowanym czasem ekspozycji, wyzwalanie zewnętrzne z czasem ekspozycji równym długości impulsu wyzwalającego.

Niektóre kamery obsługują tryb pracy wyzwalany sekwencyjnie, w którym programuje się parametry każdego obrazu w sekwencji i każdy kolejny impuls wyzwala rejestrację obrazu z innymi, zaprogramowanymi parametrami. Zmiana parametrów odbywa się w locie, przy pełnej szybkości, bez przerywania procesu akwizycji obrazów, w celu przesterowania kamery. Programowane parametry sekwencji to: ROI, czas naświetlania i wzmocnienie.

Moduł ten kontroluje proces pracy sensora i może wygenerować na wyjście sterujące kamery informację o aktualnym stanie sensora (np. rozpoczęcie lub zakończenie naświetlania).

Wzmacniacz i przetwornik A/C

Sygnał wychodzący z sensora jest wzmacniany analogowo, a następnie w przetworniku A/C jest przetwarzany na postać cyfrową. Zakresy wzmocnienia są różne, nawet do ponad 30 dB, a przetworniki A/C zwykle mają rozdzielczość na poziomie 10, 12 lub 16 bitów. Dla większości kamer użycie wzmocnienia analogowego, większego niż 50 proc. zakresu, daje już widoczny wzrost szumów. Użycie rozdzielczości bitowej większej niż 8 bitów na piksel też rzadko ma sens, bo już przy 8 bitach na piksel występują widoczne szumy, które przy zwiększonej rozdzielczości również proporcjonalnie wzrosną.

Wyższa rozdzielczość bitowa pikseli ma sens w kamerach z chłodzonym sensorem CCD.

W niektórych modelach kamer zaimplementowany jest tryb pracy automatycznej, w którym analizowany jest wybrany fragment obrazu, a wzmocnienie wzmacniacza oraz czas naświetlania ustawiane są tak, aby średni poziom sygnału z wybranego obszaru zgodny był z założonym.

Procesor graficzny

Procesor ten realizuje wstępną obróbkę obrazu w kamerze, oszczędzając czas procesora komputera. Popularne funkcje procesorów graficznych to wzmocnienie cyfrowe, odbicie lustrzane, skan częściowy (ROI, multi ROI), programowana charakterystyka pikseli (LUT, ang. Look Up Table), łączenie pikseli w poziomie i/lub pionie (binning), korekcja tła (ang. Flat Field Correction), dekodowanie barwy i balans bieli.

Procesor ten współpracuje ze wzmacniaczem w realizacji automatycznego trybu pracy.

Pamięć w kamerze

Pamięć służy do buforowania obrazów w kamerze. Jest to podstawowe rozwiązanie w kamerach szybkich. Wielkość pamięci zwykle wynosi od 2 GB do 64 GB. Rozwiązanie to jest też stosowane wkamerach standardowych. Umożliwia ono rejestrację obrazów szybszą niż możliwość transferu danych obrazowych przez interfejs. Przykładowo jest użyteczne w kamerach do nadzoru ruchu, gdzie konieczne jest rejestrowanie obrazów kilku pojazdów szybko jadącej grupy, a transfer tych obrazów może być opóźniony do momentu, kiedy jezdnia jest pusta. Zwykle wielkość pamięci RAM standardowej kamery wynosi od 16 MB do 512 MB.

Interfejs elektryczny

Interfejsy kamer można podzielić na dwa rodzaje. Jeden obejmuje wyjścia służące do przesyłania obrazu do dalszego przetwarzania lub do jego zapisu. Druga grupa to wejścia i wyjścia umożliwiające sterowanie pracą kamery.

Przesył obrazu

Aktualnie dostępnych jest wiele interfejsów transferu obrazu, od starego, analogowego Composite Video do najnowszego i najszybszego 4 × CoaXpress 6.

Praktyczne różnice między interfejsami i kryteria wyboru najlepszego interfejsu bazują na dwóch parametrach: szybkości transferu danych i dopuszczalnej długość kabla. Parametry te przedstawione są w tabeli.

Po doborze rozdzielczości sensora i niezbędnej szybkości akwizycji obrazu, można wyliczyć potrzebną szybkość transferu i zdecydować, jaki interfejs kamery zastosować. Przykładowo, przy rejestracji 30 kl/s obrazów mono, o 8-bitowej głębi szarości i rozdzielczości 2048 × 1088 px, potrzebny jest transfer rzędu 67 MB/s, więc wymagania spełnią dowolne kamery, wyposażone w interfejsy inne niż analogowy, zwykły FireWire lub USB 2.0. Aktualnie około 60–70 proc. sprzedawanych kamer ma interfejs GigE Vision.

W przypadku potrzeby rejestracji obrazów barwnych, z odkodowaniem barwy w kamerze, przy tych samych parametrach, jak w powyższym przykładzie, transfer będzie trzykrotnie wyższy, wyniesie 180 MB/s i wymagania spełnią tylko kamery z interfejsami CameraLink, USB 3.0, HSLink, agregowanym GigE Vision i CoaXpress (dwu- lub więcej kanałowym).

Wejścia i wyjścia

Kamera może pracować w trybie wyzwalania obrazów sygnałem wewnętrznym (free run) lub zewnętrznym, ale może też sygnalizować swój aktualny stan. Do tego służą wejścia i wyjścia sterujące, często optoizolowane, programowane.

Wejścia służą głównie do wyzwalania rejestracji obrazów, sterowania czasem naświetlania sensora lub do synchronizacji kilku kamer lub kamer z oświetlaczami. Na wyjścia podawane są impulsy skojarzone z wybranymi zdarzeniami w kamerze, takimi jak np. naświetlanie sensora lub odczytywanie sensora. W systemie wielokamerowym jedna kamera może sterować pozostałymi kamerami.

Przykładowo w trybie kontroli ciągłej wstęgi materiału można jedną kamerę ustawić w trybie free run, a na jej wyjście wyprowadzić sygnał informujący o naświetlaniu, który będzie podłączony do wejścia oświetlacza i wejścia drugiej kamery, skonfigurowanej na wyzwalanie zewnętrzne.

Każda kamera, poza niektórymi z USB 2.0, ma jedno wejście wyzwalania. Kamery lepszej klasy mają po dwa wejścia i dwa wyjścia optoizolowane.

Funkcje wewnętrzne kamery

Oprócz elementów mechanicznych oraz interfejsów, kamery różnią się też swoimi funkcjami, najczęściej realizowanymi programowo lub w oparciu o przetwarzanie sygnałów elektrycznych. Poniżej opisano wybrane, najważniejsze funkcje nowoczesnych kamer przemysłowych.

Czas ekspozycji

Czas ekspozycji (naświetlania) to czas między resetem ładunków pikseli a przerzutem ładunków pikseli do buforów, po naświetleniu sensora. Czas ten może być zaprogramowany w kamerze na stałe, przez integratora, albo wyznaczany przez długość impulsu wyzwalającego.

W niektórych kamerach z zaimplementowaną funkcją AutoExposure, czas ekspozycji regulowany jest przez kamerę, zależnie od średniej jasności wybranego obszaru obrazu. Podczas programowania tej funkcji ustala się, ile wcześniejszych obrazów i który fragment tych obrazów ma być użyty do wyliczenia optymalnej nastawy czasu ekspozycji.

Zależnie od konstrukcji kamery, podanie do kamery impulsu wyzwalania podczas naświetlania sensora może spowodować albo zlekceważenie tego impulsu, albo wydłużenie czasu naświetlania o pełen czas ekspozycji i w konsekwencji – prześwietlenie obrazu. Działanie takie może wystąpić, gdy impulsy zakłócające dostaną się na kabel, którym przenoszony jest sygnał wyzwalania i spowodują prześwietlanie obrazów, co mało doświadczeni integratorzy traktują jako uszkodzenie kamery.

Wzmocnienie

Tak jak wspomniano wcześniej, w kamerach CMOS każdy piksel ma swój własny wzmacniacz sygnału. Wzmacniacze te nie są identyczne i ich wzmocnienia nieznacznie różnią się, a w efekcie powstaje szum w obrazie (fixed pattern noise) – jak na rys. 6.

Sygnał z sensora CCD wyprowadzany jest przez jeden lub kilka kanałów wyjściowych (tap), za którymi znajdują się wysokiej jakości wzmacniacze analogowe. Wzmacniają one sygnały pikseli, ale i ich szumy. W wielu kamerach wzmocnienie analogowe do około połowy zakresu daje ciągle obraz z względnie małym szumem. Dalsze wzmacnianie sygnału daje obraz bardzo zaszumiony, czyli różnice jasności sąsiednich pikseli, na których zarejestrowano obszar o takiej samej jasności.

Lepiej więc nie korzystać ze wzmocnienia analogowego (ustawić Analog Gain na 0 dB), a słaby sygnał można poprawiać albo wzmocnieniem oświetlenia (najkorzystniej), wydłużaniem czasu naświetlania, albo szerszym otworzeniem przesłony obiektywu.

Tab. Aktualnie stosowane interfejsy kamer do widzenia maszynowego

| Interfejs | Analog | Cameralink base | Cameralink full | FireWire A (400 MHz) | FireWire B (800 MHz) | USB 2.0 | |

| Transfer | MB/s | 11 | 255 | 850 | 50 | 100 | 60 |

| Kabel | m | 100 | 5–10 | 5 | 4,5 | 4,5 | 5 |

| Interfejs | USB 3.0 Vision | GigE Vision | GigE Vision Link Aggreg. | HS Link | CoaXpress CXP-1 | CoaXpress 4xCXP-6 | |

| Transfer | MB/s | 350 | 125 | 250 | 2100 | 156 | 3125 |

| Kabel | m | 3 | 100 | 100 | 15 | 212 | 68 |

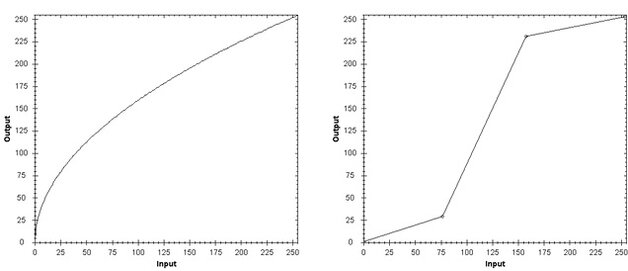

LUT

LUT to tabelka do przeliczania wartości sygnałów pikseli na inne wartości. Umożliwia zmianę dynamiki obrazu, np. wyostrzenie kontrastu lub stonowanie pewnych zakresów jasności. Sygnał wyjściowy, za przetwornikiem A/C, przechodzi przez rejestr, w którym jego wartość zastępowana jest inną wartością, z tabelki, skojarzoną z wartością wyjściową z piksela. Np. wartość sygnału piksela 128 będzie zastępowana wartością 160, jeśli w tabeli dla liczby 128 w drugiej kolumnie podana jest liczba 160.

LUT może być programowany za pomocą parametru Gamma (ciągła krzywa wykładnicza) lub linii łamanej, najczęściej trzyodcinkowej, albo ręcznie utworzonej tabeli. Dla kamery mono jest to tabelka dwukolumnowa, z liczbą wierszy odpowiadającą rozdzielczości piksela, np. 256 wierszy dla 8 b/px lub 1024 dla 10 b/px. Przykłady charakterystyki LUT przedstawiono na rys. 7.

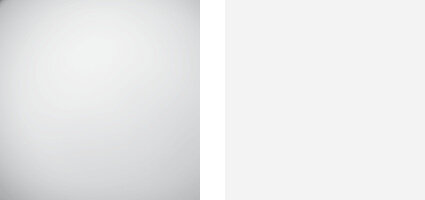

Korekcja tła – Flat Field Correction (FFC)

W realnym systemie wizyjnym równomierne oświetlenie obiektu nie jest łatwe. Dodatkowo obiektywy przyciemniają brzegi obrazów (winietowanie). W efekcie na obraz nałożona jest modulacja jasności. Aby to skompensować, w niektórych kamerach 2D i we wszystkich kamerach liniowych zaimplementowana jest funkcja Flat Field Correction (FFC). Po skalibrowaniu kamery funkcja ta koryguje wartość sygnału każdego piksela, podczas wysyłania ich z przetwornika A/C na wyjście kamery. FFC realizuje funkcję liniową sygnału wejściowego: WY = a * WE + b.

Współczynniki korekcji „a” i” b” są wyliczane podczas kalibracji kamery, która przebiega następująco:

1) zakrycie obiektywu i naświetlenie obrazu ciemnego,

2) odkrycie obiektywu, ustawienie białego ekranu w polu widzenia kamery i naświetlenie obrazu jasnego.

W obrazie jasnym ujawnia się nierównomierny rozkład sygnału, będący sumą niedoskonałości oświetlacza i obiektywu. Po uaktywnieniu funkcji FFC obrazy obiektu będą korygowane tak, aby wyrównać jasność. Kalibracja FFC jest ważna, dopóki nie zmienimy jakichkolwiek ustawień (przesłona, pole widzenia itp.).

Typowa funkcja FFC umożliwia podbicie intensywności obrazu do 2X. Dla idealnego oświetlacza i idealnego obiektywu szerokokątnego, przy kącie widzenia 65°, jasność na brzegu obrazu równa jest połowie jasności na środku obrazu. Wówczas funkcja FFC może jeszcze skompensować tę nierównomierność. Przy szerszym kącie widzenia oraz przy dodatkowych innych źródłach zakłócenia obrazu, funkcja FFC nie skompensuje w pełni nierównomierności światła na sensorze.

Rys. 7. Przykładowe charakterystyki LUT Gamma = 0,5 (po lewej) i linia łamana „centralne wyostrzenie kontrastu” (po prawej)

Binning

Binning to funkcja pozornego łączenia pikseli w grupę, przez sumowanie ich sygnałów. Funkcja ta może być realizowana w sensorze lub w procesorze graficznym.

W sensorze CCD prawie zawsze realizowany jest binning pionowy 2 × 1, czyli sumowanie dwóch kolejnych pikseli każdej kolumny. W procesorze obrazowym realizowane są bardziej zaawansowane wersje binningu: binning poziomy i pionowy, binning o różnej skali (od 2 × 1 do 8 × 8), a nawet binning barwny.

Binning sumuje wartości pikseli, a więc zmniejsza rozdzielczość obrazu, ale zwiększa jego jasność. Przykładowo w zadaniach wymagających dużej czułości kamery, zamiast szukać kamery bardzo czułej, można wybrać kamerę o wyższej rozdzielczości i włączyć binning 2 × 2, uzyskując piksel o czterokrotnie większej powierzchni, czterokrotnie mocniejszy sygnał i czterokrotne zmniejszenie rozdzielczości obrazu.

Zdarzenia

Zdarzenia w kamerze, występujące podczas jej pracy, mogą być sygnalizowane na zewnątrz za pomocą odpowiednich impulsów. Impulsy te mogą reprezentować moment wystąpienia lub długość zdarzenia, tzn. ważne jest albo pojedyncze zbocze sygnału (np. narastające), albo oba (narastające i opadające).

Zdarzenia kojarzone z impulsami wyjściowymi to m.in. początek lub koniec ekspozycji, albo też cały czas trwania ekspozycji, moment odczytu sensora, czy choćby potwierdzenie odebrania impulsu wyzwalania. Podczas ustawiania kamery można przydzielić odpowiednie zdarzenie do odpowiedniego wyjścia cyfrowego kamery i sygnał ten może być wykorzystany do kontroli lub synchronizacji systemu wizyjnego.

Dekodowanie barwy w kamerze

Kamera kolorowa jednosensorowa ma sensor monochromatyczny z matrycą mikrofiltrów RGB. Piksel jest czuły na widmo przepuszczane przez jego filtr, a nieczuły na pozostałe dwie składowe barwne. Obraz bez przetwarzania, otrzymany prosto z sensora, ma format RAW Bayer. Jest to obraz monochromatyczny z nałożona siatką. Po odkodowaniu w kamerze lub komputerze staje się obrazem barwnym.

Niektórzy producenci kamer umożliwiają odkodowywanie barw w kamerze i udostępniają wiele formatów wyjściowych (RGB, YUV). Oszczędza się w ten sposób czas procesora potrzebny do obróbki obrazów. Inni producenci nie implementują tej funkcji w kamerze i odkodowanie realizuje się w komputerze, co angażuje procesor. Brak dekodowania w kamerze tłumaczony jest minimalizacją funkcji iredukcją nagrzewania się kamery.

Asynchroniczny reset sensora

W trybie wyzwalania zewnętrznego ważnym parametrem kamery jest opóźnienie jej reakcji na sygnał wyzwalający. Opóźnienie to jest różne w różnych typach sensorów. Kamera pracuje i pobiera obrazy zsensora cały czas, od momentu włączenia zasilania. Jeśli odbiornik nie odbiera obrazów, to kamera je kasuje, ale ciągle pracuje. Jeśli w trybie wyzwalania zewnętrznego kamera otrzyma impuls wyzwalający, to zwłoka w rozpoczęciu naświetlania sensora może wynosić od 0 µs do 4–5 µs dla sensora z asynchronicznym resetem do nawet 40 µs w sensorze bez asynchronicznego resetu. Asynchroniczny reset sensora umożliwia natychmiastowe zresetowanie licznika wierszy i pikseli w wierszu. Po resecie zaczyna się naświetlanie sensora. Jeśli sensor nie ma asynchronicznego resetu, to po otrzymaniu impulsu wyzwalającego musi odczekać aż licznik pikseli w wierszu dojdzie do końca i dopiero wtedy mogą być zresetowane oba liczniki i można naświetlać sensor. Podczas obserwacji procesów szybkozmiennych, zwłaszcza w systemach wielokamerowych, asynchroniczny reset daje bardziej precyzyjną synchronizację procesu rejestracji obrazów.

Skan częściowy

W projektach wizyjnych bardzo często konieczne jest precyzyjne dopasowanie (okrojenie) pola widzenia do właściwego fragmentu obiektu. Często potrzebna jest wyższa szybkość akwizycji obrazów niż nominalna. Oba te zadania można zrealizować przez pobieranie z sensora lub wykrawanie w kamerze tylko fragmentu obrazu.

W sensorach CMOS jest to realizowane bez problemów. Z sensora odczytuje się tylko wartości wybranych pikseli. Producenci sensorów CCD udostępniają dwa, trzy lub cztery formaty skanu częściowego (ROI), umożliwiając zwiększenie szybkości odczytu sensora. Niektóre rodziny kamer mają zaimplementowaną w procesorze graficznym funkcję ROI wycinającą z obrazu sensora CCD dowolnie wybrany fragment. Z sensora wyczytywany jest cały obraz, a w procesorze wycinany jest fragment i ten fragment jest wysyłany interfejsem wizyjnym do komputera. Jeśli wąskim gardłem transferu obrazów jest sensor, funkcja ROI nie przyspieszy akwizycji obrazów. Jeśli wąskim gardłem jest interfejs wizyjny, a sensor ma rezerwy szybkości, realizacja ROI w procesorze może zwiększyć szybkość transferu danych (kl/s).

Wysyłanie obrazu ograniczonego tylko do ważnego fragmentu zmniejsza zapotrzebowanie na moc obliczeniową komputera i przyspiesza analizę obrazu.

Lustrzane odbicie

Prawie wszystkie kamery obsługują funkcję odbicia lustrzanego: w pionie

i/lub w poziomie. Funkcja ta może być realizowana w sensorze lub w procesorze wizyjnym. Może ona być pożyteczna, jeśli nie mamy możliwości dowolnego zamocowania kamery w systemie wizyjnym, achcemy aby obiekt widoczny był tak, jak w lustrze. Jak każda funkcja realizowana w kamerze, tak i ta nie zabiera czasu procesora komputera i nie opóźnia wyniku analizy obrazu.

Przykłady doboru kamer

Znajomość omówionych cech kamer pozwala na samodzielny dobór komponentów systemów wizyjnych. W dalszej części artykułu zaprezentowano przykłady aplikacji, w których w oparciu o wcześniej podane rady, wybrano konkretne rodzaje kamer przemysłowych.

Prosta aplikacja

W przypadku, gdy nie ma żadnych wymagań szczególnych, tj. obiekt jest stacjonarny, bardzo kontrastowy i konieczna jest jedynie ocena jego obecności lub kompletności, np. wykrycie obecności kilku otworów Ø5 w płytce blaszanej 80 mm × 60 mm, można przeprowadzić następującą analizę:

- przyjąć, że piksel ma być trzykrotnie mniejszy niż otwór, co oznacza, że powinien on mieć długość 1,66 mm,

-

w przypadku pola widzenia 80 mm × 60 mm potrzebna jest kamera z sensorem o rozdzielczości:

80/1,66 × 60/1,66 = 48 × 36 px.

Ponieważ dostępne kamery mają odpowiednie parametry, warto wybrać najtańszą.

OCR, OCV i rozpoznawanie kodów

W celu skutecznego rozpoznawania obecności oraz barwy lub odcienia obiektu, przynajmniej jeden piksel powinien oddawać wiernie barwę lub odcień szarości obiektu. Stanie się tak, gdy na minimalny szczegół obiektu zostaną skierowane co najmniej dwa piksele. Jeden z nich powinien całkowicie pokryć dany szczegół. Pewniejsze jest jednak celowanie trzema pikselami w wybrany szczegół. Jako szczegół należy rozumieć najcieńszą linię rysunku lub najcieńszą linię czcionki lub punkt czcionki „dot matrix”.

Przykłady prezentacji w obrazie litery „a” przy różnych rozdzielczościach zostały przedstawione na rys. 9.

Firma Dalsa doradza dobór rozdzielczości kamer 2D:

- dla kodów kreskowych – 3 px na najcieńszą linię,

- dla kodów 2D – 4 px na punkt kodu,

- dla OCR/OCV – 20 × 20 px na typowy znak alfanumeryczny.

Proste zadanie pomiarowe

W tym przypadku nie ma wymagań szczególnych: obiekt jest stacjonarny, bardzo kontrastowy, a pomiar bezpośredni widocznego elementu. Brak też wymagań dotyczących czasu cyklu pomiarowego. Przykładem może być pomiar średnicy kilku otworów Ø5 ±0,1 mm w cienkiej płytce blaszanej o wymiarach 80 mm × 60 mm. Można wtedy przeprowadzić następującą analizę:

- Błąd pomiaru ma wynosić 20 % pola tolerancji, czyli 20 % z 0,2 mm – 0,04 mm, z czego na rozdzielczość warto przydzielić 1/3 dopuszczalnego błędu, tj. 0,0133 mm – taką wielkość piksela zakładamy.

- W przypadku pola widzenia 80 mm × 60 mm potrzebna jest kamera z sensorem o rozdzielczości 80/0,0133 × 60/0,0133, czyli 6015 × 4511 px. Wymagania te spełnia kamera o rozdzielczości 29 Mpx, np. AVT Prosilica GT6600 (6576 × 4384 px). Zawężenie tolerancji średnicy do 0,05 mm powoduje, że nie ma kamery, której sensor wystarczyłby do tego pomiaru z jednego obrazu. Należy więc zastosować kilka kamer. Można rozważyć kamerę VN firmy Vieworks z sensorem 29 Mpx zamocowanym na piezoceramice. W wyniku interpolacji można uzyskać rozdzielczość efektywną 9 × 29 Mpx = 261 Mpx.

Obiekt w ruchu

Wymagania: złącze klejone na płycie meblowej ma szerokość od 0,1 mm; należy ocenić występowanie wypływek kleju w świetle UV, w trakcie ruchu płyty z prędkością 1 m/s w kierunku równoległym do ścieżki kleju. Potrzebne jest rozwiązanie ekonomiczne.

Analiza:

- Dla wykrycia ścieżki kleju o szerokości od 0,1 mm można dobrać piksel dwukrotnie mniejszy, czyli 0,05 mm.

- W przypadku obiektów ruchomych, aby obraz nie był rozmazany (wyraźny kontur wypływek kleju), czas ekspozycji sensora powinien być nie większy niż czas przemieszczenia obiektu o ½ piksela. Przy ruchu 1 m/s i wymiarze piksela 0,05 mm, czas ekspozycji musi wynosić nie więcej niż 25 µs. Tylko niektóre kamery mają tak krótki czas ekspozycji. Dodatkowo kamera powinna być bardzo czuła (preferencja dla CCD), a oświetlacz bardzo mocny, w miarę możliwości strobowany.

- Szerokością sensora kamery trzeba pokryć odcinki o jakie płyta przemieszcza się między kolejnymi ekspozycjami, np. dobierając kamerę 5 Mpx, o rozdzielczości 2540 × 2050 px, uzyskamy dokładność do 0,05 mm, przy polu widzenia 127 mm, co przy małym nakładaniu się obrazów, pozwoli uzyskać rejestrację obrazów co około 120 mm, czyli 8,3 kl/s. Kamery 5 Mpx, z sensorem Sony ICX625 lub ICX655, będą wystarczające pod względem rozdzielczości i szybkości, ale mają czasy naświetlania większe niż 25 µs.

- Problem zbyt długiego czasu ekspozycji kamery można obejść stosując oświetlacz błyskowy, np. LED, który może błyskać impulsami o podwyższonej mocy, o czasie trwania od 1 µs.

- Użycie kamery o niższej rozdzielczości sensora, np. 1280 × 960 px, da pole widzenia 64 mm × 48 mm i wymaga rejestracji obrazu co około 60 ms lub szybkości 17 kl/s. Wymagania takie spełnia kamera AVT Manta G-125B, z czasem ekspozycji od 21 µs i szybkością do 30 kl/s, przy pełnej rozdzielczości.

- Aby przyspieszyć obróbkę sygnału, korzystnie byłoby wyciąć tylko fragment obrazu (skan częściowy) i takie dane wysyłać do komputera. Większość kamer, w tym Manta, ma funkcję ROI w kamerze. Do tego zadania pasuje m.in. kamera AVT Manta G-125B.

Bardzo wysoka rozdzielczość

Przykładem aplikacji, w której potrzebna jest bardzo duża rozdzielczość, jest testowanie wyświetlaczy LCD. Panel LCD Full HD ma 2048 px w linii, ale jeden piksel to zwykle trzy lub sześć subpikseli, amiędzy nimi wąskie czarne ramki. Pełen katalog wad paneli LCD zawiera m.in. defekty o wielkości ułamka subpiksela. Przy założeniu, że wykrywać będziemy minimalny defekt równy 1/2 subpiksela i przy założeniu, że subpiksel ma szerokość około 1/4 szerokości piksela – jeden defekt matrycy Full HD to 1/(2048 × 4 × 2) = 0,00006 jej szerokości. Planując wykrywanie defektów z założeniem, że piksel ma być dwukrotnie mniejszy niż defekt i cały panel LCD zostanie objęty jednym obrazem, potrzebna będzie kamera o rozdzielczości 32 768 px w poziomie, a przy ekranach o proporcjach 4:3 sensor musiałby mieć rozdzielczość 805 Mpx.

Możliwe rozwiązania tego problemu to:

a) przeskanowanie panelu LCD kamerą liniową – wystarczy kamera liniowa o rozdzielczości 16 kpx, skanująca wzdłuż dłuższego boku ekranu, pozwalająca uzyskać obraz o rozdzielczości 512 Mpx. Koncepcja ta stawia jednak bardzo wysokie wymagania na dokładność sprzężenia ruchu kamery, względem kontrolowanego panelu LCD;

b) zastosowanie czterech kamer o rozdzielczości 261 Mpx, każda pokrywająca obszar 1/4 panelu z małą zakładką. Firma Vieworks produkuje kamery serii VN, z sensorem do 29 Mpx (6576 × 4384), zamontowanym na piezoceramice, która umożliwia przesuwanie sensora o 1/2 lub 1/3 piksela w poziomie i w pionie. 9 naświetleń sensora z przesunięciem o 1/3 w pionie i poziomie daje łącznie obraz oefektywnej rozdzielczości 9 × 29 Mpx = 261 Mpx.

Fotoradary

Duża część zdjęć z fotoradarów nie nadaje się do wykorzystania. Winę za to ponoszą m.in. zmienne warunki oświetlenia i mało elastyczna konfiguracja sprzętowa. Fotoradar pracuje 24 godziny na dobę: wnocy, w pochmurne dni i w słońcu – z tyłu lub od frontu obiektywu. Aby dopasować kamerę do bardzo zmiennych warunków świetlnych, należy dobrać model o bardzo dużej dynamice albo oszybkozmiennych parametrach ekspozycji.

Jednym z lepszych rozwiązań kamer o wysokiej dynamice jest model dwusensorowy, w którym obraz z obiektywu rozdzielany jest na dwa sensory, pracujące z różnymi czasami naświetlania iwzmocnieniami. Sumaryczny obraz zawiera niezbędne szczegóły: zarówno czytelny numer rejestracyjny pojazdu, jak i wyraźną twarz kierowcy.

Innym problemem fotoradarów są lokalne silne odblaski w polu widzenia kamery, pochodzące od światła słonecznego, lub od lampy błyskowej fotoradaru. Stosowane w wielu starszych polskich fotoradarach kamery mają sensor CCD, który przy lokalnym prześwietleniu najpierw wykazuje efekt powiększenia prześwietlanego obszaru na obszar niedoświetlony (blooming), a przy większym prześwietleniu tworzy pionowy jasny pas przez cały obraz (smear). Oba te efekty mogą uniemożliwić odczytanie tablicy rejestracyjnej lub rozpoznanie twarzy kierowcy.

Efektów blooming i smear nie wykazują sensory CMOS. Dlatego znaczący producenci kamer do widzenia maszynowego mają w swoim portfolio kamery do nadzoru ruchu – wszystkie z sensorami CMOS, gwarantują podniesienie jakości obrazów. Wysokiej jakości sensory CMOS mają też funkcje HDR (High Dynamic Range), z jedno- lub dwukrotnym ponownym naświetlaniem prześwietlonych pikseli.

Powierzchnie połyskujące

Powierzchnie metalowe, szklane, a nawet niektóre plastiki i papier mogą wywoływać lokalne silne odblaski, które w wyniku efektów blooming i smear powodują uszkadzanie obrazów z kamer z sensorami CCD. Dlatego w projektach z użyciem silnych źródeł światła, np. linii laserowej lub mocnego oświetlacza punktowego, gdy istnieje ryzyko powstania odblasku od powierzchni obiektu, optymalnym rozwiązaniem jest użycie kamery z sensorem CMOS. Przypadkowy lokalny odblask w polu widzenia kamery, często w obszarze nieistotnym dla wyniku analizy obrazu, spowoduje lokalne prześwietlenie pikseli, ale nie wpłynie to na pozostałą część obrazu, która może być poddana analizie.

Duża dynamika światła – obiekt stacjonarny

Opisane fotoradary wymagają kamer o wysokiej dynamice i dużej szybkości reakcji. Szybko jadący samochód pozostaje w polu widzenia kamery tylko przez 10–20 ms. W przypadkach szybkozmiennych warunków świetlnych na obiektach statycznych optymalne mogą być kamery z funkcją wyzwalania sekwencyjnego. Kamera taka ma programowalne parametry akwizycji kilku kolejnych obrazów. Kolejne impulsy wyzwalają rejestrację kolejnych klatek, z parametrami zmiennymi w locie. Z góry można zaprogramować do 10 zestawów parametrów, na które składają się: czas naświetlania, wzmocnienie i ROI. Po rejestracji sekwencji obrazów program analizuje je i wybiera do analizy obraz najlepiej naświetlony. Może też przeanalizować kilka obrazów, uzyskując efekt dynamiki lub analizy ruchu.

Wyzwalanie sekwencyjne jest standardową funkcją kamer serii Compact, firmy JAI.

Skaner 3D

Skanery 3D to ostatnio bardzo modny temat. Istnieją dwie koncepcje budowy skanerów 3D:

- Standardowa kamera 2D + projektor prążków – dla obiektów stacjonarnych. Zadanie to nie stawia specjalnie zaawansowanych wymagań dla kamery. Zwykle im wyższa rozdzielczość kamery, tym lepsza dokładność pomiarów 3D. Jak zwykle w zadaniach pomiarowych stosuje się kamery monochromatyczne.

- Kamera 2D/3D + linia świetlna (laserowa lub z projektora LED) – dla obiektów w ruchu, naturalnym lub wymuszonym przez skaner. Powolny skaner można zbudować na bazie standardowej kamery 2D. Szybkie skanery wymagają kamery 3D, czyli kamery 2D z obróbką obrazu w kamerze, dającej na wyjściu profile linii z poszczególnych obrazów. W kamerze 3D wyznaczanie profilu linii na obiekcie jest tym szybsze, im niższy fragment sensora (ROI) używany jest do analizy. Szybkość skanowania wynika więc z ustawienia kamery na pewien zakres pomiarów w osi Z (wysokości). Niektóre kamery 3D mają funkcję ROI śledzącego, która umożliwia przesuwanie ROI w momentach, gdy obraz linii na sensorze zbliża się do granicy aktualnego ROI. Kamera z taką funkcją (np. firmy Automation Technology) osiąga najwyższą możliwą szybkość skanowania 3D, wyższą niż kamera ze sztywno ulokowanym ROI. Z analizy potrzebnej szybkości skanowania wyniknie decyzja, czy kamera musi mieć śledzący ROI, czy nie.

Obiekt w ruchu

Do rejestracji obiektów w ruchu potrzebna jest szybka kamera i mocne oświetlenie. W kamerach szybszych niż kamery standardowe klasy szybkości można powiązać z szybkościami interfejsów. Tanie kamery z interfejsem GigE Vision uzyskują transfer do 120 MB/s, więc kamera z sensorem 2 Mpx umożliwi otrzymanie maksymalnie 60 kl/s. Kamera 2 Mpx z interfejsem CameraLink Full pozwoli uzyskać do 400 kl/s, a z czterokanałowym interfejsem

CoaXpress – do 1560 kl/s. Szybkie kamery mają sensory CMOS, które po ograniczeniu pola widzenia (ROI), gwarantują wyższą szybkość akwizycji obrazów.

Szybkość kamer z pamięcią RAM zależy od przepustowości wewnętrznej magistrali. W popularnych szybkich kamerach występuje transfer rzędu 1,5 GB/s, co przy obrazie o rozdzielczości 2 Mpx daje szybkość 750 kl/s.

Przy rejestracji szybkich obrazów, jeśli zależy nam na ostrym obrazie, należy dobrać czas ekspozycji równy czasowi przesunięcia obiektu o 1/2 piksela. Jeśli kamerą z sensorem 1280 × 1024 px obserwujemy z boku zderzenie samochodu, przy prędkości 50 km/h, w polu widzenia o wymiarach 4 m × 3 m, z szybkością 1000 kl/s, to piksel na obiekcie ma wymiar 4000/1280 = 3,12 mm, a przemieszczenie 3,12 mm, przy prędkości 50 km/h trwa 252 µs. Pożądany czas ekspozycji to 126 µs. Nie jest to mało, ale wystarczająco mocne oświetlenie tak dużego obszaru będzie trudnym wyzwaniem.

Rys. 9. Przykład doboru rozdzielczości, tj. liczby pikseli na linię litery: 1. znak wygenerowany syntetycznie 13 pikseli na linię pionową litery; 2. sześć pikseli na linię; 3. 3,5 piksela na linię i 20 × 20 pikseli na znak; 4. trzy piksele na linię; 5. dwa piksele na linię. Znak pierwszy z prawej, z dwoma pikselami na linię, ze względu na zakrzywienia linii jest słabo czytelny, a po progowaniu na poziomie 128 zostałby rozdzielony na trzy oddzielne fragmenty. Algorytmy OCR/OCV nie rozpoznałyby w nim litery „a”

Dokładny system pomiarowy

Wizyjne systemy pomiarowe wysokiej dokładności to najtrudniejsza grupa zadań widzenia maszynowego. Tworzenie dokładnego systemu pomiarowego to duże wyzwanie nawet dla doświadczonych integratorów. Przy wyborze kamery, poza typowymi cechami, takimi jak rozdzielczość i szybkość, należy uwzględnić wszystko, co spowoduje, że krawędzie obiektu będą najdokładniej odwzorowane w pikselach obrazu:

- niskie szumy kamery wskazują na użycie sensora CCD;

- duży współczynnik fill factor – większość standardowych kamer ma sensory z mikrosoczewkami na pikselach. Bez mikrosoczewek na pikselach CCD i CMOS tylko 30–40 proc. powierzchni byłoby światłoczułe. Dzięki mikrosoczewkom światło jest zbierane w dużej części obszaru piksela i skupiane na obszarze światłoczułym. 100-proc. fill factor jest niezbędny w przypadku zamiaru użycia rozdzielczości podpikselowej. Taki parametr mają kamery liniowe, wymagające zbudowania precyzyjnego skanera, oraz niezbyt przyjazne w użyciu kamery z sensorem CCD Full Frame lub Frame Transfer. Nadzieje integratorów budzą coraz popularniejsze kamery z sensorem oświetlanym od tyłu (backside illuminated);

- brak efektów blooming i smear wskazuje na zastosowanie sensorów CMOS, a nie CCD, jak wnioskowano powyżej;

- funkcja FFC (Flat Field Correction) jest zalecana, jeśli oświetlenie nie jest idealnie równomierne, a obiektyw wykazuje znaczące winietowanie. W przypadku użycia progowania (threshold) w algorytmach wyszukiwania krawędzi lub blobów korzystne może być użycie kamery z funkcją korekcji tła. Funkcja ta koryguje wartości pikseli, kolejno piksel po pikselu, podczas szeregowego pobierania danych z sensora. Praktycznie nie opóźnia to momentu wyprowadzenia danych obrazowych z kamery. Funkcja ta jest standardowo implementowana w kamerach liniowych. W kamerach 2D jest to rzadkość, ale można ją spotkać w modelach wyższej klasy (np. firm Dalsa lub JAI).

Obrazy barwne

Wytyczne odnośnie doboru rozdzielczości kamery do obiektu są inne dla kamer monochromatycznych i kolorowych trójsensorowych, a inne dla kamer kolorowych jednosensorowych. Piksel monochromatyczny powinien być na obiekcie dwa, trzy razy mniejszy niż najmniejszy szczegół obiektu. Teoria mówi o pikselu dwukrotnie mniejszym, ale praktycy doradzają piksel trzy razy mniejszy.

Dla kamery kolorowej, jednosensorowej, z interpolacją barw 2 × 2 lub 3 × 3, rozdzielczość kamery powinna być dwu- lub trzykrotnie wyższa, niż 2–3 px na szczegół, zależnie od typu interpolacji barw. Tak więc jeden piksel powinien stanowić od 1/4 do 1/9 najmniejszego rozpoznawanego szczegółu obiektu.

W przypadku kamery trójsensorowej wystarczą, tak jak w kamerze mono, 2–3 px na szczegół.

Kamery kolorowe należy stosować tylko w przypadkach oceny obiektów wielobarwnych. W przypadku prostej oceny barw, np. przy wykrywaniu obiektów o barwie wyraźnie innej niż barwa tła, można użyć kamery monochromatycznej i odpowiednio selektywnego światła lub filtru.

Podsumowanie

System wizyjny, będący połączeniem kamery i komputera, ma przewagę jakościową nad systemem z kamerą zintegrowaną (inteligentną), dzięki znacznie większym możliwościom wyboru kamer przetwarzania danych. Kamery zintegrowane (inteligentne kamery i sensory) mają natomiast przewagę przy prostych zadaniach. Wówczas czas tworzenia systemu i koszt integracji mogą być niższe, a dzięki upakowaniu wszystkich elementów w jednej obudowie konstrukcja systemu będzie bardziej zwarta.

Problem jednak w tym, że w prototypowych zadaniach na początku trudno jest ocenić skalę problemu i optymalnie wybrać konfigurację sprzętową. Dopiero podczas realizacji projektu wychodzą na jaw problemy, które nie były rozpatrywane w fazie ofertowej i wówczas okazuje się, czy wybrana koncepcja systemu (kamera + komputer albo kamera zintegrowana) ma wystarczający potencjał rozwojowy, czy nie.

Na kamerze bazuje cały system, gdyż to ona tworzy obraz i przekazuje do programu informacje o obiekcie. Wybranie najlepszej kamery do zadania nie gwarantuje jednak, że system będzie działał poprawnie.

Do kompletnego rozwiązania zadania wizyjnego potrzebne jest optymalne dopasowanie wszystkiego: oświetlacza, obiektywu, kamery i algorytmu. Komputer często nie jest elementem krytycznym dla niezawodnej realizacji zadania, dlatego kamera zintegrowana (inteligentna), ze słabym procesorem w środku, wystarczy do realizacji wielu zadań wizyjnych.

W systemach wizyjnych najważniejsza jest jednak nie marka sprzętu, nie jego wydajność i cena, ale integrator, jego wiedza, doświadczenie i zaangażowanie w temat.

Marek Kania

source: PAR 10/2014