Big Data nie tylko dla Przemysłu 4.0

Małgorzata Kaliczyńska (Łukasiewicz – PIAP) drukuj

Wśród kluczowych technologii, które przyczyniają się do realizacji koncepcji Przemysłu 4.0 jest analiza dużych zbiorów danych – Big Data. W wyniku cyfryzacji procesów produkcyjnych transformacji ulegają stosowane w przemyśle metody oraz narzędzia – inteligentne czujniki, maszyny, systemy IT sterujące procesami, a nawet obrabiane przedmioty generują dane, które mogą być przetwarzane on-line lub off-line, przyczyniając się do optymalizacji i/lub maksymalizacji łańcucha wartości.

Pod pojęciem Big Data kryje się zdolność do zbierania, przechowywania i analizowania ogromnej ilości danych, których analiza może być wykorzystana do identyfikowania nieefektywności i wąskich gardeł produkcyjnych, optymalizacji produkcji i maksymalizacji jej jakości, oszczędności energii i poprawy serwisu oraz diagnostyki urządzeń. W kontekście Przemysłu 4.0 gromadzenie i kompleksowa ocena danych z wielu różnych źródeł – urządzeń i systemów produkcyjnych, a także systemów zarządzania przedsiębiorstwami i klientami – stanie się standardem mającym na celu wspieranie procesu decyzyjnego w czasie rzeczywistym.

Prawdziwym potencjałem Przemysłu 4.0 jest tworzenie nowych, inteligentnych sposobów działania – przez automatyzację i robotyzację, inteligentne maszyny i zaawansowaną analitykę, a wszystko wspierane przez narzędzia informatyczne – w tym rozwiązania internetowe. Metody i technologie IIoT są stosowane w celu obniżenia kosztów i zwiększenia wydajności, bezpieczeństwa i ostatecznie zysków. Jednak przyszłość musi być zintegrowana z chmurą, która następnie może połączyć lokalne aplikacje w większe systemy regionalne lub globalne, aby stać się siecią systemów, które w pełni wykorzystają potencjał analityki Big Data dla przemysłu.

Big Data jest określeniem relatywnie nowym, po raz pierwszy zastosowano tę nazwę w 1999 r., jednak zbieranie i przechowywanie dużych ilości danych i informacji do celów analitycznych praktykowane było od bardzo dawna. Eksploracja danych, drążenie danych, pozyskiwanie wiedzy, wydobywanie danych, ekstrakcja danych (ang. data mining) jest jednym z etapów procesu odkrywania wiedzy. Idea eksploracji danych polega na wykorzystaniu szybkości komputera i jego mocy obliczeniowej do znajdowania ukrytych dla człowieka (głównie z uwagi na ograniczony czas) prawidłowości w zgromadzonych danych. Istnieje wiele technik eksploracji danych, tym samym automatycznego odkrywania nieoczywistych zależności, schematów, wzorców, reguł w zbiorach danych, które wywodzą się z ugruntowanych dziedzin nauki, takich jak statystyka (statystyczna analiza wielowymiarowa) oraz uczenie maszynowe.

Największym wśród dużych zbiorów danych jest Internet. Jego eksploracja (ang. web mining) bazuje na przytoczonych już technikach. Mówiąc o Przemyśle 4.0, skupiamy się głównie na analizie gromadzonych w Internecie danych pochodzących z urządzeń Przemysłowego Internetu Rzeczy IIoT (ang. Industrial Internet of Things). Ten obszar dopiero rozwija się, a stosowane metody analizy zbiorów danych bliższe są działaniom diagnostycznym i predykcyjnym [3, 4].

IIoT to jednak przede wszystkim urządzenia, które towarzyszą nam w codziennym życiu – notebooki, tablety, smartfony, smartwache, a także naszpikowane elektroniką samochody, zdalnie nadzorowane inteligentne domy i szereg innych, które są niemal na stałe skomunikowane z siecią. Do tego media społecznościowe, aplikacje internetowe. Sami tworzymy zasoby Big Data. Co z tego wynika? Brak anonimowości w Internecie. Sieć obserwuje nas i próbuje nas zrozumieć, żeby dostosować się do naszych potrzeb, a przede wszystkim, by je wykreować.

Mówiąc o Big Data, by zrozumieć ich sens w kontekście Przemysłu 4.0, warto rozejrzeć się wokół siebie i poznać powszechnie stosowane metody analizy gromadzonych o nas danych – danych wydawałoby się prywatnych. Przetwarzanie bardzo dużej ilości danych, technologie informatyczne i informacyjne oraz media społecznościowe wpływają na nasze życie przez operowanie na prywatnych zbiorach naszych danych.

Skąd tak dużo danych?

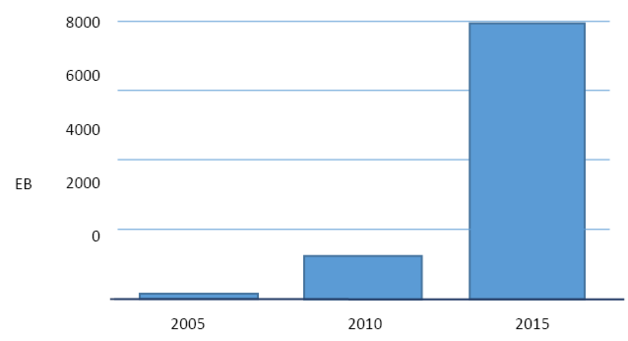

Ilość informacji, a właściwie danych, bo informacje to dane przetworzone, wytworzonych na świecie rośnie w ogromnym tempie. Zbiory Biblioteki Aleksandryjskiej – największej biblioteki świata starożytnego, która funkcjonowała w okresie od III wieku p.n.e. do IV wieku n.e. moglibyśmy dziś zapisać na 12 krążkach DVD (rys. 1). Zasoby Internetu zgromadzone w 2010 r. to już statek kontenerowy cały wypełniony płytami DVD. Zasoby te wciąż rosną. Warto zwrócić również uwagę na jakość i wartość tych zasobów – jedno nieudane i nieciekawe selfie to zdecydowanie więcej bitów niż zapisana w formacie elektronicznym książka zawierająca wiele użytecznych informacji.

Zasoby światowego Internetu wciąż rosną. W 2015 r. wytworzono dane o objętości 7,9 EB (rys. 2). W ciągu dwóch lat (2014–2015) powstało więcej danych niż wytworzono od początku ludzkości do 2013 r. Ponieważ są to już wielkie liczby, warto spojrzeć na przeliczniki definiujące kolejne jednostki informacji i stosowane akronimy.

kilobajt 1 kB = 1000 B

megabajt 1 MB = 1000 kB

gigabajt 1 GB = 1000 MB

terabajt 1 TB = 1000 GB

petabajt 1 PB = 1000 TB

eksabajt 1 EB = 1000 PB

zettabajt 1 ZB = 1000 EB

jottabajt 1 YB = 1000 ZB

Zaprezentowane liczby i wielkość gromadzonych danych wynikają z tego, że rozpatrywane dane to nie tylko dane użyteczne. Ich wielkość wynika z faktu, że efekty wszelkiej działalności są zapamiętywane. Obecnie gromadzone są dane wynikające z wielu aktywności, m.in. internautów. Czy są przetwarzane? Jeśli pojawi się taka potrzeba – tak. W większości przypadków są archiwizowane i gotowe do przetwarzania, jeśli zajdzie taka konieczność.

Co dzieje się w ciągu 60 sekund w Internecie? Zamieszczona infografika (rys. 3) przedstawia średni przyrost różnych form i struktur danych w trakcie jednej minuty w 2017 r. W tym czasie zaobserwowano m.in. następujące formy aktywności:

- ponad 3,8 mln wyszukiwań w Google,

- ponad 243 000 opublikowanych zdjęć w medium społecznościowym Facebook,

- ponad 350 000 opublikowanych tweetów,

- ponad 65 000 zdjęć opublikowanych na Instagramie,

- 120 nowych kont utworzonych na portalu LinkedIn,

- ponad 156 mln wysłanych e-maili,

- ponad 800 000 plików zapisanych na Dropboxie,

- ponad 2 000 000 połączeń przez Skype’a,

- ponad 80 zarejestrowanych nowych domen,

- ponad 500 000 pobranych aplikacji.

Big Data – Big Brother?

Aktywności zaprezentowane na infografice są rejestrowane, wszystkie dane są przechowywane. Wszyscy korzystamy z wyszukiwarki internetowej Google, ale najczęściej nie zdajemy sobie sprawy z tego, co dzieje się dalej. Google przechowuje wszystkie zapytania każdego użytkownika (włączając adres IP) przez dziewięć miesięcy. Potem usuwa tylko końcówkę adresu IP. Te wszystkie dane są przechowywane przez firmy niemal bez ograniczeń – mogą się przydać w przyszłości, kiedy nauka pozwoli wydobywać ukrytą wiedzę. Powstaną wtedy nowe algorytmy i wówczas dane staną się użyteczne. Obecnie gromadzone treści są wykorzystywane jedynie w około 20%.

Analizując wyniki działania wyszukiwarki, najczęściej nie zdajemy sobie sprawy z tego, że Google nie pokazuje stron globalnie odpowiadających na zadane pytanie, które są najczęściej klikane, ale te, które odpowiadają profilowi użytkownika, bo taki profil jest rejestrowany. Profil użytkownika jest określany m.in. przez wiek, płeć, znajomość języków obcych, a przede wszystkim wcześniej wyszukiwaną tematykę. Google dobiera wyniki zgodnie z zainteresowaniami i profilem użytkownika. Podobnie działa Facebook – nie pokazuje wszystkiego, co udostępniają nasi znajomi, ani co lubią nasi znajomi, lecz „przejmuje władzę” i sam decyduje, co nas zainteresuje. Filtrowanie pod kątem zainteresowań i gustów jest nazywane bańką filtrującą.

Mechanizm ten wpływa na nasze postrzeganie rzeczywistości zarówno pozytywnie, jak i negatywnie. Bańka filtrująca utrwala poprzednie postawy i wypacza sposób myślenia, gdyż dostarcza tylko część informacji. Potrzeba stosowania bańki filtrującej (opracowanie odpowiednich algorytmów) wiąże się z tym, że możliwych danych jest tak dużo. Nie chodzi tu o obiektywną reprezentację danych, ale pokazanie tego, co może być potrzebne. I dokładnie w tym momencie, kiedy przetworzone informacje są potrzebne.

Można zaobserwować, że coraz bardziej zależy nam na prywatności. Czy można nie zgodzić się na tę inwigilację? Wystarczy – w przypadku Facebooka – nie publikować postów, zdjęć, nie używać chatu ani Messengera i nie lajkować innych postów. Z czasem na naszej tablicy przestaną się pojawiać aktualne posty naszych znajomych – przestaniemy też być atrakcyjni dla tego medium.

W przypadku wyszukiwarki Google jest trochę gorzej, bo chętnie korzystamy ze spersonalizowanych wyników wyszukiwania – szybkich i dokładnie odpowiadających naszym potrzebom. Jest jednak konkurencyjny projekt realizowany przez NSA i Apple. To wyszukiwarka DuckDuckGo – https://duckduckgo.com/, która odpowiada na 10 milionów zapytań dziennie. W porównaniu z Google wynik ten jest mizerny, ale DuckDuckGo nie zbiera i nie udostępnia informacji na temat swoich użytkowników. Nie zasypuje ich spamem, takim jak spersonalizowane reklamy. Wyniki wyszukiwania opiera wyłącznie na treści wpisanego w polu wyszukiwania hasła. Korzystając z niej, można być w pełni anonimowym.

Fundamenty Big Data

Zasoby danych, o których mówimy, to dane cyfrowe. Ich ilość jest podwajana średnio co dziewięć miesięcy. Najczęściej nie mamy pomysłu, jak je wykorzystać, ale warto je przechowywać – kiedyś mogą się przydać. W niektórych obszarach zastosowań te zbiory są już przetwarzane. By gromadzić dane, konieczne jest ich przesyłanie – komunikacja, a także źródła danych. Fundamentem dla dużych zbiorów będą komputery o dużych mocach obliczeniowych, szybkie pamięci o dużej pojemności, połączenia światłowodowe oplatające wszystkie kontynenty (najczęściej prowadzone na dnie mórz i oceanów), tworzące globalną sieć – wszechobecny Internet. Po co to? Mając ogromne zbiory danych, można tworzyć modele różnych zjawisk. Na modelu można ćwiczyć, przewidywać przyszłość, a przede wszystkim rozwiązywać problemy.

Superkomputery

Sunway TaihuLight, system opracowany przez chiński National Research Center of Parallel Computer Engineering & Technology oraz zainstalowany w National Supercomputing Center w Wuxi w Chinach już po raz czwarty utrzymuje swoje pierwsze miejsce w rankingu superkomputerów [10]. Najważniejszym parametrem benchmarku jest High Performance LINPACK. Mierzy on szybkość rozwiązywania gęstego układu równań liniowych, opisującego standardowe zagadnienia spotykane w problemach inżynieryjnych i naukowych. Benchmark ten jest używany do porównywania szybkości działania komputerów, wyrażonej w liczbie wykonywanych operacji zmiennoprzecinkowych na sekundę. W przypadku superkomputera TaihuLight liczba ta wynosi 93,01 PFLOPS.

Na drugiej pozycji listy Top 500 już po raz czwarty uplasował się superkomputer Tianhe-2 (Milky Way-2), system opracowany przez chiński National University of Defense Technology (NUDT) i wdrożony w National Supercomputer Center w Guangzhou w Chinach z wynikiem testu LINPACK na poziomie 33,86 PFLOPS. Wcześniej sześciokrotnie zajmował pierwsze miejsce w rankingu.

Najszybszy komputer świata – Sunway TaihuLight jest w pełni produktem chińskim. Nie zastosowano w nim amerykańskiej technologii i jest trzykrotnie szybszy od poprzednika. Przy trzykrotnie wyższej mocy obliczeniowej charakteryzuje się mniejszym zużyciem energii. Jego moc obliczeniowa może osiągnąć w szczycie (Rpeak) wartość 125,435 PFLOPS. Liczba użytych procesorów to 40 960, każdy po 260 rdzeni. Łączna liczba rdzeni to 10 649 600. Procesory są taktowane zegarem o częstotliwości 1,45 GHz (poprzednik 2,2 GHz). Pamięć operacyjna wynosi 1 310 720 GB (1,31 PB).

![Rys. 3. [https://www.go-globe.com/wp-content/uploads/2017/08/60-seconds.gif] – Things that happen on Internet Every 60 Seconds 2017 Statistics [7] Rys. 3. [https://www.go-globe.com/wp-content/uploads/2017/08/60-seconds.gif] – Things that happen on Internet Every 60 Seconds 2017 Statistics [7]](/var/aol/storage/images/media/images/60sekund/603518-1-pol-PL/60sekund_large.png)

Rys. 3. [https://www.go-globe.com/wp-content/uploads/2017/08/60-seconds.gif] – Things that happen on Internet Every 60 Seconds 2017 Statistics [7]

Pamięci

Zgodnie z prawami Moore’a, moc obliczeniowa współczesnych komputerów podwaja się co 18 miesięcy. Komputery są nie tylko coraz bardziej wydajne, ale i coraz mniejsze. Jednak obserwacja ilości gromadzonych danych pozwala stwierdzić, że ich wielkość podwaja się zdecydowanie szybciej. To skłania naukowców do poszukiwania rozwiązań pozwalających zminimalizować wymiary dysków i zwiększyć ich wydajność/pojemność. Twórcy dysków twardych Hitachi szacują, że ich pamięci wymagają około 800 000 atomów nośnika magnetycznego do zapisu jednego bitu, który przyjmuje jedną z dwóch wartości – 0 lub 1. Skrajnym przeciwieństwem, a tym samym wartością docelową do zapisania jednego bitu byłby jeden atom. W styczniu 2012 r. w IBM opracowano technologię zapisu jednego bitu w strukturze antyferromagnetycznej. Grupa naukowców [6] zaczęła eksperymentować z magazynowaniem magnetycznym w bardzo niskich temperaturach, startując od jednego atomu azotku miedzi Cu3N (później atomu żelaza), ostatecznie tworząc strukturę złożoną z 12 atomów. Miała ona dwa rzędy po sześć atomów. Rozwiązanie to działa w niskiej temperaturze – na poziomie 1 Kelvina, czyli około –458 stopni Fahrenheita. Zwiększając temperaturę do wartości pokojowej, twórcy tej pamięci zakładają, że jeden bit będzie potrzebował około 150 atomów, co i tak jest ogromnym sukcesem. W efekcie to małe urządzenie pamięci masowej pozwoli zamiast 1 TB w klasycznym wykonaniu gromadzić od 100 TB do 150 TB. Jednak jest jeszcze większy problem. Nikt nie ma pojęcia, jak zbudować coś tak małego poza laboratorium. I na pewno nie można zrobić tego tanio. Wynalazek ten stanowiłby przełom, który jeszcze przez dziesięciolecia nie trafi na dyski twarde lub pamięci USB, ale daje wskazówkę, jakie mogą być kierunki rozwoju pamięci magnetycznych.

Źródła danych

Największe zasoby danych tworzą media społecznościowe. Ich analiza oraz zawartości blogów i forów pozwala oceniać nastroje, wykrywać zmiany trendów, przewidywać wyniki sondaży (np. wyniki wyborów). Odrębnym źródłem są komputery, które komunikują się ze sobą oraz boty, które tworzą treści i zamieszczają je na Facebooku lub w innych mediach. Ogromne zasoby danych stanowią bazy danych i hurtownie – w odróżnieniu od zasobów internetowych mają one postać uporządkowaną, ustrukturyzowaną. Ważnym i coraz bardziej dominującym źródłem danych są urządzenia Internetu Rzeczy – kamery, czytniki RFID, komputery wbudowane, samochody, inteligentne budynki, inteligentne liczniki energii, urządzenia GPS i szereg innych. Ogromny zasób danych i informacji stanowi Deep Web – jego wielkość jest co najmniej 1000-krotnie większa niż zasoby indeksowane przez tradycyjne wyszukiwarki internetowe.

3 V, 4 V, 10 V a może 100 V?

Termin Big Data pojawił się podobno po raz pierwszy w mediach w 1999 r. Pierwsze próby scharakteryzowania Big Data podjęto w 2001 r. Zrobiono to za pomocą kilku elementów V. Na początek było to 3 V:

- Volume (ilość) – firmy generują setki TB informacji, zbierają dane z różnorodnych źródeł: transakcje biznesowe, media społecznościowe, dane z sensorów, dane wymieniane między urządzeniami; 6 miliardów mieszkańców Ziemi ma telefony komórkowe, które mają dostęp do Internetu i w każdej chwili generują różne dane (zdjęcia, filmy, posty, e-maile, SMS i inne). Szacuje się, że do 2020 r. dane będą zajmować 40 ZB, co oznacza 300-krotne zwiększenie zasobów w stosunku do 2005 r.

- Variety (różnorodność) – różne formy i źródła danych, takie jak urządzenia do noszenia (zestawy urządzeń lub urządzeń elektronicznych, które są częścią naszego ubrania lub części ciała, stale współpracujące z użytkownikiem i innymi urządzeniami w celu wykonania określonej funkcji). Obuwie z GPS i opaski na rękę, około 420 mln bezprzewodowych urządzeń monitorujących, które kontrolują nasze zdrowie, są przykładami wielu nowych technologii, które staną się popularne w krótkim czasie. W 2011 r. globalny rozmiar danych związanych z ochroną zdrowia dochodził do 150 EB. Co miesiąc oglądane jest ponad 4 miliardy godzin filmów na YouTube. Dane mają różne formaty – od ustrukturyzowanych, numerycznych danych w tradycyjnych bazach danych do niestrukturalnych dokumentów tekstowych, e-mail, video, audio, danych znaczników magazynowych lub transakcji finansowych.

- Velocity (szybkość) – dane powstają i są dostarczane niezwykle szybko i muszą być obsługiwane z odpowiednim reżimem czasowym – analiza w czasie rzeczywistym (znaczniki RFID, czujniki i inteligentne mierniki wymagają obsługi olbrzymich ilości danych w czasie zbliżonym do rzeczywistego; nowoczesny pojazd ma ponad 100 czujników, które monitorują wszystko, co dzieje się w środowisku, m.in. ciśnienie w oponach, poziom paliwa, obecność przeszkód na drodze itp.). Największa giełda świata New York Stock Exchange przetwarza 1 TB danych finansowych podczas każdej sesji. W 2016 r. istniało około 18,9 mld różnych sieci komputerowych – oznacza to, że na każdego mieszkańca Ziemi przypadają 2,5 połączenia z sieciami.

W 2012 r. uzupełniono charakterystykę Big Data o kolejne V (Veracity), w wyniku czego powstał model 4 V.

- Veracity (wiarygodność) – informacje ułatwiają podejmowanie wiarygodnych decyzji. Jeden na trzech liderów biznesu nie ma zaufania do danych, których używa do podejmowania decyzji. 27% respondentów podczas jednego badania stwierdziło, że nie wie, jak wiele danych jest niedokładnych.

Z czasem kolejnych cech przybywało, np. Variability oraz Value.

- Variability (zmienność) – odnosi się do danych, których znaczenie stale się zmienia. Jest to wyraźnie widoczne w mediach społecznościowych, gdy jakiś temat jest szczególnie popularny. Czasami trudno jest zarządzać danymi napływającymi w szczycie dziennym, sezonowym czy wywołanym konkretnym wydarzeniem. Taka sama dana może mieć różne znaczenie w zależności od kontekstu. Jest to jeszcze trudniejsze w przypadku danych niestrukturalnych. Tutaj znaczenie jest związane z tzw. sentymentem, który może być w różnym stopniu pozytywny lub negatywny. Wówczas potrzebne są zaawansowane programy, które pomogą „zrozumieć” kontekst i rozszyfrować za jego pośrednictwem dokładne znaczenie słów.

- Value (wartość) – potencjalna wartość Big Data jest ogromna. Jednak koszt złych danych jest równie olbrzymi. W istocie dane same w sobie są praktycznie bezwartościowe. Wartość jest tworzona podczas rygorystycznej analizy dokładnych danych, a także dzięki informacjom i spostrzeżeniom, które to zapewnia. Big Data bez analizy i wizualizacji jest bezwartościowa. Dane i analizy są w pełni wzajemnie zależne – jedne bez drugich są praktycznie bezużyteczne, ale ich moc jest właściwie nieograniczona.

W kolejnych latach liczba elementów opisu Big Data zwiększyła się o kolejne V, dochodząc do wartości 10 V, a nawet 42 V. Niektórzy znawcy tematu przychylają się nawet do 100 V. Poniżej przytoczę w porządku alfabetycznym wszystkie 42 V, pomijając ich znaczenie i opis. Sądzę, że znajdą się ciekawi czytelnicy, którzy zajrzą na blog [9] i zgłębią dokładnie temat. Dodam, że ten intrygujący wpis został zamieszczony 1 kwietnia 2017 r. A teraz obiecana lista 42 V opisujących Big Data oraz Data Science:

Vagueness, Validity, Valor, Value, Vane, Vanilla, Vantage, Variability, Variety, Varifocal, Varmint, Varnish, Vastness, Vaticination, Vault, Veer, Veil, Velocity, Venue, Veracity, Verdict, Versed, Version Control, Vet, Vexed, Viability, Vibrant, Victual, Viral, Virtuosity, Viscosity, Visibility, Visualization, Vivify, Vocabulary, Vogue, Voice, Volatility, Volume, Voodoo, Voyage, Vulpine.

Podstawy analizy danych

Proces analizy danych składa się z kilku etapów [1, 2]:

- Capture (zdobycie) – czujniki i sensory (temperatura, światło, wysokość, ciśnienie, dźwięk, które przetwarzają fizyczne lub chemiczne wielkości i przekształcaja je w dane). Istnieją od dziesięcioleci, ale pojawienie się komunikacji bezprzewodowej (Wi-Fi, Bluetooth, RFID itp.) zrewolucjonizowało świat czujników.

- Transformation (przekształcenie) – po znalezieniu źródeł niezbędnych danych kolejnym krokiem jest zgromadzenie danych zebranych w tym samym miejscu, ich formatowanie i transformacja (konwersja danych i czyszczenie brudnych danych). Stosowane są platformy ETL (Extract, Transform and Load). Są to narzędzia wspomagające proces pozyskania danych dla baz danych, szczególnie dla hurtowni danych. Zadaniem narzędzi ETL jest: pozyskanie danych ze źródeł zewnętrznych, przekształcenie danych, załadowanie danych do bazy danych (zazwyczaj będącej hurtownią danych).

- Storage (magazynowanie) – przechowywanie w sposób bardziej elastyczny, ułatwiający manipulowanie dużą ilością danych znacznie szybciej niż tradycyjne bazy danych, zarówno modele o strukturze relacyjnej – bazujące na SQL, jak i NoSQL – dynamiczne i elastyczne struktury danych

- Analysis (analiza) – na tym etapie najczęściej stosowane są trzy główne techniki:

- Association (asocjacja, skojarzenie) – polega na znalezieniu relacji między różnymi zmiennymi, danymi.

- Data Mining (eksploracja danych) – ma na celu predykcyjne określenie przyszłego zachowania. Obejmuje zestaw technik, które łączą metody statystyczne oraz uczenie maszynowe.

- Clustering (grupowanie, analiza skupień) – dzieli duże zbiory danych na mniejsze grupy, celem jest znalezienie podobieństwa między danymi, jednak bez stosowania wzorców. Podstawą grupowania jest podobieństwo elementów wyrażone za pomocą funkcji podobieństwa. Przez grupowanie można również rozwiązać problemy z gatunku odkrywania struktury w danych oraz dokonywania uogólnień.

- Display (wizualizacja) – obraz jest wart tysiąca słów lub tysiąca informacji. Łatwiej jest interpretować dane wyświetlane na wykresach lub mapach niż w tabelach wypełnionych liczbami lub tekstem.

Interpretacja analizy danych

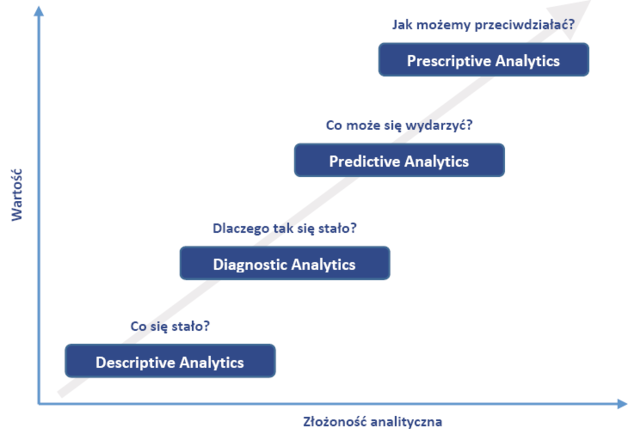

Analiza danych jest procesem sprawdzania, oczyszczania, przekształcania i modelowania ich. Wykonuje się ją po to, by znajdować przydatne informacje, sugerować wnioski i wspierać proces podejmowania decyzji w oparciu o fakty (rys. 4). Pierwszym i zarazem najprostszym typem jest analityka opisowa (Descriptive Analytics). Wspiera ocenę danych pod kątem tego „Co się stało?”. Kolejny etap to analityka diagnostyczna (Diagnostic Analytics) – pomaga znaleźć odpowiedź na pytanie „Dlaczego tak się stało?”. Wymienione metody są dosyć proste – mają małą złożoność analityczną, co znaczy, że główny ciężar analizy danych i podejmowania decyzji spoczywa na człowieku. Są to metody skupione na analizie przeszłości, stanowią punkt wyjścia do rozważań – co robić, by błędu nie powtórzyć.

Analityka opisowa (podstawowy element analizy) pokazuje nam, co dzieje się w naszych procesach w sposób łatwy do zrozumienia. Analiza historycznych danych pozwala określić, co się stało i dlaczego.

Kolejne dwa typy analityki to analityka predykcyjna (Predictive Analytics) oraz analityka preskryptywna (Prescriptive Analytics). One wspierają i automatyzują podejmowanie decyzji – wyciągają wnioski na podstawie poprzednich analiz.

Techniki analizy predykcyjnej i preskryptywnej pomagają przekształcić dane w wiedzę i decyzje. Analiza predyktywna pozwala przewidywać, co się stanie, a analiza preskryptywna pomaga określić najbardziej korzystne decyzje.

Zadaniem analizy predykcyjnej jest próba odpowiedzi na pytanie „Co może się wydarzyć?”. Analityka preskryptywna znajduje optymalne rozwiązania umożliwiające kontrolowanie i wpływanie na zmiany w zachodzących procesach biznesowych. Mówiąc prościej: algorytm bierze pod uwagę wszystkie znane mu czynniki, przewiduje konsekwencje różnych decyzji i na tej podstawie proponuje najlepsze rozwiązanie. W efekcie otrzymujemy odpowiedź na pytanie „Jak możemy przeciwdziałać?”.

W analityce preskryptywnej stosowane są specjalistyczne i zaawansowane algorytmy wspierające optymalizację.

Kto korzysta z Big Data?

Ilość danych, które są wytwarzane i archiwizowane w skali globalnej ciągle rośnie. Niestety, tylko mały procent danych jest rzeczywiście analizowany. Oznacza to niewykorzystany potencjał istotnych informacji. Co to oznacza dla biznesu? Dane są zbierane przez różne instytucje, np. telekomy, banki, biblioteki, uniwersytety, administrację. Mają jasną, czytelną budowę. Wcale nie oznacza to jednak, że ich analiza i wykorzystanie w określonym celu jest proste. Problemem pozostaje przetwarzanie olbrzymiej liczby rekordów, tak aby zmniejszyć koszty, zredukować czas, wytworzyć nową ofertę produktową, podjąć lepsze decyzje. Jeśli połączymy dane masowe z zaawansowaną analizą danych, możemy wspomóc różne procesy biznesowe.

Jak wcześniej zaznaczono, ogromna ilość danych pozwala zbudować model organizacji, procesu, działań. Zweryfikowany model jest doskonałym narzędziem do oceny przeszłości, dokładności identyfikacji problemów, wykrywania anomalii (incydentów specjalnych) a także identyfikacji nastrojów. W dalszej kolejności prawidłowy model umożliwia ocenę w czasie rzeczywistym, wskazuje regularności, trendy. Ogromną zaletą opracowanego modelu jest przewidywanie, głównie predykcja incydentów szczególnych.

Przykładowe efekty analityki Big Data mogą się wiązać z wykrywaniem przyczyn awarii w zakładzie przemysłowym, nieprawidłowej pracy urządzeń oraz uszkodzeń w czasie rzeczywistym. W handlu poznanie zwyczajów zakupowych klientów i śledzenie ścieżek, jakimi się poruszają pozwala zmodyfikować układ towarów na półkach, by przyniosły lepszy efekt finansowy. Analiza finansowa umożliwia wykrywanie działań wskazujących na nadużycie (np. w banku) lub określanie ryzyka portfela giełdowego.

Big Data wpływa na rozwój organizacji praktycznie w każdym sektorze rynku – w bankowości, edukacji, w instytucjach publicznych, w ochronie zdrowie, handlu detalicznym (budowa relacji z klientami), a także w produkcji – zwiększenie wydajności procesów produkcyjnych oraz ograniczenie strat. W zależności od charakteru biznesu oraz potrzeb dane biznesowe mogą pochodzić z różnych źródeł. Mogą to być dane własne – system CRM, strona WWW firmy, sklep on-line, newslettery, media; dane innego podmiotu – dostępne przy współpracy, a także dane kupione.

Analiza Big Data po polsku

Badaniem Big Data – ogromnych zbiorów informacji, które znajdują się w cyberprzestrzeni – zajmują się od kilku lat z sukcesem naukowcy z Katedry Technologii Informacyjnych Mediów na Wydziale Dziennikarstwa, Informacji i Bibliologii Uniwersytetu Warszawskiego [8]. Zajmowali się m.in. badaniem wpływu ustawy o IPN na wizerunek Polski, preferencjami politycznymi. Rozwiązując postawiony problem, już po kilku dniach potrafią podać wynik i zależnie od tematu określić trendy.

Opracowane przez zespół algorytmy korzystają ze źródeł, które można analizować w czasie rzeczywistym. Są to fora internetowe, blogi i inne otwarte dane. Natomiast znaczna część prac związanych ze zbieraniem danych na zadany temat prowadzą boty internetowe. Gdyby robili to tradycyjni analitycy, to zapewne odpowiedź uzyskaliby za rok. Musieliby ściągnąć dane, przeczytać je, przeanalizować i policzyć. Tutaj odpowiedź pojawia się błyskawicznie.

Naukowcy przyszłości nie potrafią przewidywać, ale doskonale identyfikują procesy zachodzące w cyfrowej przestrzeni informacyjnej. Porównując je ze zjawiskami ekonomicznymi lub politycznymi, potrafią prognozować, jak będą się rozwijały w przyszłości. Doświadczenie i wyniki prac naukowców z Uniwersytetu Warszawskiego zostały zauważone przez Narodowe Centrum Badań i Rozwoju – agencję wykonawczą Ministra Nauki i Szkolnictwa Wyższego, wspierającą innowacyjność w Polsce.

W ramach projektu identyfikują zależności statystyczne między określonymi zjawiskami, badają występujące między nimi związki przyczynowo-skutkowe. Odpowiadają na pytania, czy w niedalekiej przyszłości konkretne technologie mogą przynieść efekty ekonomiczne. Dodatkowo NCBiR chce wiedzieć, czy pojawiają się nowe technologie, w które warto zainwestować, a oni jeszcze o tym nie wiedzą. Działania tej grupy zahaczają o potrzeby Przemysłu 4.0 – dla NCBiR badali zasadność inwestowania w modną ostatnio elektromobilność, czyli budowę pojazdów elektrycznych. W wyniku przeprowadzonych badań okazało się, że problemem jest magazynowanie energii. Odpowiedź na pytanie, czy opłaca się inwestować w elektromobilność, jest prosta. Tak, opłaca się, ale najlepsze efekty osiągnie ten, kto zbuduje lepszą baterię. Dziś taki potencjał mają państwa, które mają dostęp do złóż litu. Te zaś znajdują się w Afryce i Afganistanie, a tam już inwestują firmy amerykańskie i chińskie...

![Rys. 5. Samochód autonomiczny Waymo [autor Grendelkhan, licencja CC BY-SA 4.0 [https://commons.wikimedia.org/w/index.php?curid=56611386] Rys. 5. Samochód autonomiczny Waymo [autor Grendelkhan, licencja CC BY-SA 4.0 [https://commons.wikimedia.org/w/index.php?curid=56611386]](/var/aol/storage/images/media/images/waymo_self-driving_car_front_view.gk/603521-1-pol-PL/Waymo_self-driving_car_front_view.gk_large.jpg)

Rys. 5. Samochód autonomiczny Waymo [autor Grendelkhan, licencja CC BY-SA 4.0 [https://commons.wikimedia.org/w/index.php?curid=56611386]

W kierunku Przemysłu 4.0

1. Waymo – samochód autonomiczny Google

Firma Google pracuje od 2009 r. nad rozwojem autonomicznych samochodów. Samochody, których używają w tym projekcie, są wyposażone w kamery, GPS, połączenie z Internetem oraz szereg komputerów wbudowanych i sensorów, które pozwalają bezpiecznie poruszać się po drogach publicznych bez ingerencji człowieka (rys. 5).

Nazwa Waymo pochodzi od realizowanej misji: „a new way forward in mobility”. Waymo nie ma kierownicy, pedału gazu ani pedału hamulca – jest w 100% pojazdem autonomicznym. Został zaprojektowany tak, by wykrywać pieszych, rowerzystów, inne pojazdy, roboty drogowe oraz wszelkie obiekty z odległości bliskiej wymiarom dwóch boisk do piłki nożnej we wszystkich kierunkach. Jest to jedno z największych wyzwań Big Data, ponieważ komputer musi przetwarzać ponad milion danych na sekundę.

2. Amazon

Amazon – wielki lider e-commerce ma system Big Data, który pozwala mu wysłać produkt do centrum dystrybucji, zanim klient go zamówi. Jest w stanie przewidzieć niezawodnie pragnienia plany zakupowe swoich klientów, co ułatwia realizowanie zamówień w nowym systemie dostaw w mniej niż dwie godziny po dokonaniu zakupu (Prime Now). Jego zastosowanie stanowi prawdziwą transformację modeli logistycznych i napędza pozostałe firmy w sektorze w kierunku obowiązkowej transformacji, która pozwoli im zoptymalizować zarządzanie logistyką, aby zapewnić użytkownikowi natychmiastową reakcję wymaganą przez świat cyfrowy.

3. Big Data w transporcie i logistyce – Sateliun

Sektor logistyki i transportu generuje ogromne ilości danych, które można wykorzystać przy użyciu technologii Big Data. Sateliun łączy narzędzia geolokalizacyjne i zarządzanie pojazdami za pomocą GPS i Big Data, w celu określenia bardziej wydajnych tras, a co za tym idzie oszczędności czasu i paliwa. System wyświetla również zaktualizowany stan sieci dróg w czasie rzeczywistym, co poprawia efektywność, szczególnie w dużych aglomeracjach miejskich. Śledzenie towarów jest dokładniejsze, a bardziej wiarygodne prognozy mogą dotyczyć zapotrzebowania na usługę, dzięki czemu firma może wejść na rynek i wydajniej zarządzać zleceniami.

4. Big Data w firmie spedycyjnej

UPS jest firmą spedycyjną, która gromadzi olbrzymie ilości danych – większość z nich pochodzi z czujników zamontowanych w pojazdach. Dane te wykorzystywane są nie tylko do monitorowania codziennych działań i wyników, ale także do wprowadzania modyfikacji optymalizujących trasy i grafiki kierowców UPS. Zastosowany system ORION (On-Road Integrated Optimization and Navigation) stanowi zapewne największy na świecie projekt z zakresu badań operacyjnych. Jest on także ściśle związany z geograficznymi danymi umieszczonymi na mapach, które są dostępne on-line. W dalszej perspektywie ma modyfikować odbiory i dostarczanie przesyłek przez kierowcę w czasie rzeczywistym.

Realizacja projektu przyniosła już znaczne korzyści: udało się zmniejszyć zużycie paliwa o około 10 mln galonów, dzięki skróceniu dziennych tras o 85 mln mil. Szacuje się, że emisja CO2 zmniejszyła się o 100 000 ton. Według wyliczeń UPS skrócenie trasy każdego kierowcy o 1 milę dziennie pozwala firmie zaoszczędzić 30 mln dolarów, więc w ogólnym rozrachunku są to znaczne oszczędności.

5. Kontrola parametrów farb w zakładach Mercedes-Benz

Fabryka Mercedes-Benz w Vitorii jest drugim co do wielkości zakładem Daimler AG na świecie. Vitoria jest m.in. światowym liderem w produkcji samochodów dostawczych średniej wielkości. Doświadczeni eksperci z Vitorii koordynują międzynarodową produkcję, od strategii narzędziowej, poprzez logistykę, po zarządzanie jakością. Fabryka znajduje się w sercu Kraju Basków w północno-zachodniej Hiszpanii. Pierwszy pojazd zjechał tutaj z linii w 1954 r. W fabryce Mercedes-Benz wykorzystywane są czujniki optyczne do zbierania informacji o około 200 parametrach związanych z jakością farby. Pomiary są prowadzone dla każdego z 700 samochodów dostawczych, które opuszczają linię produkcyjną każdego dnia. Dane te są wykorzystywane do przewidywania sytuacji, identyfikowania wzorców i gromadzenia wiedzy o zachowaniu maszyny podczas procesu produkcyjnego. W tym przypadku pomagają one poświadczać kontrolę jakości farby każdego z pojazdów.

6. Inteligentne opony Michelin

W kopalniach odkrywkowych Południowej Ameryki, Afryki i Australii w bardzo trudnych warunkach pracują 200-tonowe ciężarówki, każda o wartości 3,5 mln dolarów, które przewożą ładunki o masie do 400 ton po stromych zboczach, w bardzo trudnych warunkach. Tutaj najmniejszy problem – awaria ma ekstremalne znaczenie techniczne i operacyjne. Dla operatorów maszyn w kopalniach unieruchomienie sprzętu stanowi najgorszy scenariusz. Problemem jest zmiana opony, która ma ponad 4 m średnicy i masę 5 ton. Takie działanie często wymaga więcej niż osiem godzin pracy. Michelin Group – producent opon – wprowadził na rynek inteligentny system Evolution3 o nazwie MEMS (Michelin Earthmover Management System) z czujnikami wodoodpornymi, które dostarczają informacji o parametrach opon – temperaturze i ciśnieniu. Każda opona ma wbudowaną łączność 3G i może wysyłać dane w czasie rzeczywistym. Może nawet wysyłać powiadomienia za pośrednictwem poczty e-mail lub wiadomości SMS, jeśli przekroczone zostaną progi temperatury lub ciśnienia. System wykrywa też powolne straty ciśnienia i umożliwia przewidywanie i unikanie unieruchomienia ciężarówki. Wykrycie wzrostu temperatury umożliwia optymalizację trasy i jej zmianę w czasie rzeczywistym. W razie potrzeby łatwiej jest przewidzieć również czynności konserwacyjne. W ten sposób wzrasta rzeczywisty czas jazdy ciężarówek. Zwiększono bezpieczeństwo, wydłużono żywotność opon, obniżono koszty i zwiększono wydajność kopalni.

Bibliografia

1. Yáńez F., The Goal is Industry 4.0: Technologies and Trends of the Fourth Industrial Revolution, ISBN: 978-1-9734-1317-2.

2. Yáńez F., The 20 Key Technologies of Industry 4.0 and Smart Factories The Road to the Digital Factory of the Future: The Road to the Digital Factory of the Future, ISBN: 978-1-9734-0210-7.

3. Gilchrist A., Industry 4.0: The Industrial Internet of Things, Apress Media, 2016, DOI: 10.1007/978-1-4842-2046-7.

4. Hyunjoung L., Il S., Big Data w przemyśle: Jak wykorzystać analizę danych do optymalizacji kosztów procesów?, Wydawnictwo Naukowe PWN, Warszawa 2016.

5. Averous J., The Fourth Revolution – How to Thrive Through the World’s Transformation, Fourth Revolution Publishing, 2011, ISBN: 978-9-6710-3580-1.

6. McMillan R., IBM Brains Turn 12 Atoms into World’s Smallest Storage Bit – [https://www.wired.com/2012/01/ibm-scientists/], 01.12.2012.

7. Things that happen on Internet Every 60 Seconds – [https://www.go-globe.com/blog/things-that-happen-every-60-seconds/].

8. Żemła E., Analitycy Big Data – współcześni wróżbici? Niezwykły projekt polskich naukowców – [wiadomości.onet.pl], 17.05.2018.

9. Shafer T., The 42 V’s of Big Data and Data Science – [https://www.elderresearch.com/blog/42-v-of-big-data].

10. TOP500 Lists – [https://www.top500.org/lists/top500].

źródło: Automatyka 6/2018

![Rys. 1. Światowe zasoby opublikowane do 2010 r. [5] Rys. 1. Światowe zasoby opublikowane do 2010 r. [5]](/var/aol/storage/images/media/images/book-schem-04/603512-1-pol-PL/book-schem-04_large.png)

Komentarze

blog comments powered by Disqus