Systemy wizyjne w kontroli jakości

Marek Kania drukuj

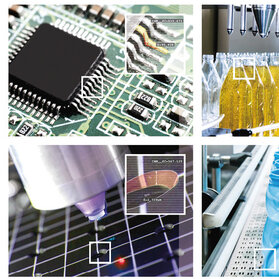

Technologie wizyjne coraz częściej znajdują zastosowanie do kontroli jakości, czyli sprawdzania zgodności produktu z projektem, w tym wymiarowej, wykonawczej oraz zgodności cech. Firmy, które nie wykorzystują wizyjnej kontroli procesów zazwyczaj nie znają możliwości technologii wizyjnych lub mają złe doświadczenia z wdrożeniami niedopracowanych systemów wizyjnych.

Kontrolą jakości produktów lub stabilnością procesu zajmuje się człowiek lub automat. Człowiek jest powolny i omylny, chociaż potrafi zareagować w nieprzewidziany sposób (np. wykryć nowy typ defektu). Automat może być szybki i niezawodny (o ile jest sprawny), a przypadki niestandardowe może pomóc wykrywać poprzez zarchiwizowanie obrazu i/lub informacji. Dane z archiwum umożliwiają późniejsze udoskonalanie algorytmu analizy obrazów.

Człowiek czy komputer?

Jedyna zaleta, ale i wada człowieka, a właściwie oka ludzkiego, jako inspektora, to akomodacja. Oko płynnie dostosuje się do zmiennych warunków otoczenia, ale nie dostrzeże powolnych zmian w barwie lub jasności obiektu. Płynnie ustawi też ostrość na różne dystanse, bez dostrzeżenia, jak mała jest głębia ostrości. Każde nowe spojrzenie na jakiś cel wywołuje trzy zdarzenia: skierowanie osi oka na centrum celu, dostrojenie źrenicy do jasności obiektu i dostrojenie soczewki do dystansu do obiektu.

Wad systemu „oko + mózg” jest natomiast kilka: wysoka rozdzielczość oka tylko w pobliżu jego osi, a niska poza nią, długi czas percepcji obrazu i jego analizy w mózgu (dziesiąte części sekundy), brak stabilności zapamiętania wzorca obrazu oraz duża zawodność lub niemożność porównywania obrazów z zapamiętanym wzorcem.

Zaletami systemu „kamera + komputer” są: wysoka i równomierna rozdzielczość w całym polu widzenia, zdolność zapamiętania obrazu odniesienia, szybkość rejestracji obrazu oraz szybka analiza obrazu w komputerze.

Dlaczego inspektor nie wystarczy?

W jednej z fabryk produkujących panele LCD do telewizorów zastanawiano się nad celowością użycia systemów wizyjnych do inspekcji tych paneli. Panele sprawdzane były przez inspektorów analizujących wygląd kolejnych ekranów testowych. Operator miał około 1 s na ocenę poprawności jednego obrazu na 40” panelu. Dział Jakości wierzył, że taka kontrola jest skuteczna. Z analizy możliwości oka wynika jednak, że inspekcja nie jest skuteczna, a zastąpienie operatora przez system wizyjny jest koniecznością. Jeśli ekran (40”) ma wymiar 885 × 500 mm, założymy (z nadmiarem), że oko ma dobrą rozdzielczość w polu widzenia nie większym niż 100 ×100 mm, a czas reakcji inspektora na zaobserwowany defekt wynosi 0,1 s, to ekran 40” wymaga 9 × 5 = 45 spojrzeń, po 0,1 s, czyli obserwacji przez 4,5 s. Inspekcja jednego ekranu testowego w krótszym czasie, np. 1 s, to w efekcie kontrola wyrywkowa, a nie 100%.

Dla porównania, kamera lub zespół kamer, może zarejestrować obraz całego ekranu w ciągu kilku milisekund, a komputer przeanalizuje go w kilkadziesiąt milisekund. Sekunda wystarczy na 100% analizę kilku ekranów testowych. Przy analizie obrazów w FPGA (Field Programmed Gate Array), a nie w procesorze komputera, analiza obrazu możliwa jest w czasie poniżej 1 ms.

Przykład z innej branży to inspekcja dużych powierzchni w celu wykrycia drobnych defektów – przy kontroli wzrokowej albo nie da się wyłapać wszystkich defektów, albo inspekcja wymaga odpowiednio długiego czasu.

Odpowiednik akomodacji oka, którą można uznać za jego zaletę i wadę, można też znaleźć w kamerach. Przykładowo rodzina kamer Sony FCB ma funkcje autofocus, autoexposure, autogain, czyli pełną automatykę. Dodatkowo mają one automatyczny balans bieli i regulowany z aplikacji zoom, funkcje niedostępne w oku ludzkim.

Jeśli system wizyjny jest dopracowany i analizuje obrazy za pomocą poprawnych algorytmów, jest on znacznie skuteczniejszy od człowieka. Pracuje bardzo powtarzalnie i nie dekoncentruje się po kilku godzinach pracy.

Warto jeszcze porównać system wizyjny do tradycyjnego czujnika. Najtańsze kamery mają 640 × 480 pikseli, czyli fotodiod i każda może być wykorzystana jako samodzielny fotodetektor lub czujnik. Daje to możliwość szybkiej analizy co najmniej 300 000 punktów na powierzchni obiektu. Stąd ta wydajność systemów wizyjnych. Typowy czujnik ma jeden detektor, kontrolujący stan tylko jednego punktu obiektu. Możliwości systemu wizyjnego, nawet w postaci inteligentnego sensora, są nieporównywalnie większe niż zwykłego czujnika. Oczywiście jest wiele zadań, w których informacja 1-punktowa o obiekcie wystarczy i tradycyjny czujnik spełni swoją rolę.

Wydajność – zaleta inspekcji wizyjnej

System wizyjny z kamerą o rozdzielczości 0,3–5 Mpx, oświetlenie ze strobowaniem i w miarę szybkim komputerem jest w stanie rejestrować i analizować 20–50 obrazów na sekundę, przy prostym zadaniu, jak szukanie krawędzi lub analiza blobów. Stosowanie bardziej zaawansowanych funkcji analizy obrazów, jak np. dopasowanie do wzorów (pattern matching), może wymagać czasu analizy kilkuset milisekund.

Po zaprogramowaniu odpowiedniej obróbki obrazu na FPGA karty akwizycji obrazów, uzyska się wyniki analizy obrazu, czyli setki tysięcy lub miliony pikseli, w ciągu 1 ms lub szybciej. Żadna inna technologia pomiarowa nie ma takiej wydajności przetwarzania informacji.

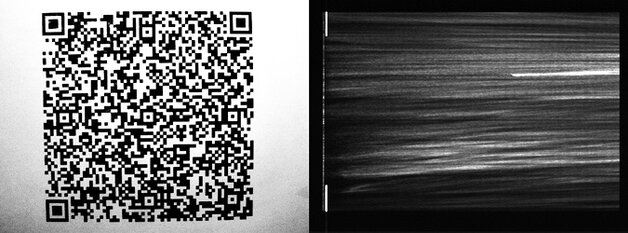

W praktyce rzadko wykorzystuje się pełną wydajność przetwarzania informacji systemu wizyjnego. Najczęściej analiza ograniczana jest do fragmentów obrazów lub wręcz do niedużej liczby pikseli, tych niosących ważne informacje pomiarowe. Wówczas można osiągnąć znacznie szybszą analizę obrazu. Przykładami pełnego lub znacznego wykorzystania powierzchni sensora są skanery z kamerami liniowymi lub kamery w czytnikach kodów 2D bądź kamery 2D w skanerach 3D z projekcją prążków.

Wysoka wydajność to nie jedyna zaleta systemu wizyjnego w porównaniu z człowiekiem (inspektorem). Inne zalety to stabilność wzorca zapamiętanego przez komputer i wysoka niezawodność porównań kolejnych obrazów z tym wzorcem, w przeciwieństwie do elastycznego oka i mózgu ludzkiego.

Jeśli zapanujemy nad oświetleniem i wzmocnieniem kamery na tyle, że poziom sygnału każdego piksela będzie zawierał wiarygodną informację analogową o obiekcie, to mamy jeszcze więcej informacji o nim. Można np. zacząć pracę w rozdzielczości podpikselowej lub traktować kamerę jako matrycę mikroczujników.

Wysoka wydajność i równoległe przetwarzanie dużej ilości informacji w systemach wizyjnych to potężne narzędzie do zarządzania procesem produkcyjnym.

Badane cechy obiektów

Ponieważ piksele kamery są fotodetektorami, to kontroli wizyjnej podlegać mogą tylko cechy wizualne:

- geometria obiektu: wymiary, kształt konturu, poprawność lub kompletność wykonania, defekty powierzchni, przemieszczenia lub odkształceń obiektu itp. – badane na podstawie analizy wielu sąsiadujących pikseli,

- powierzchnia obiektu: barwa, odcienie szarości, temperatura – badane na podstawie analizy sygnału każdego pojedynczego piksela.

Inspekcja wymiarów i konturów

Najprostszym zadaniem wizyjnym i najmniej narażonym na błędną pracę systemu jest analiza konturu obiektu widzianego na tle oświetlacza dyfuzyjnego (back light). W przypadku prostej geometrii obiektu, np. szerokości otworu klucza, pomiar niskiej dokładności zrealizuje prosty algorytm szukania krawędzi, napisany przez początkującego integratora. Przy wymaganej wysokiej dokładności pomiaru konieczne jest skalibrowanie systemu na wzorcu, ustabilizowanie oświetlacza i oświetlenia otoczenia (np. przez ekrany).

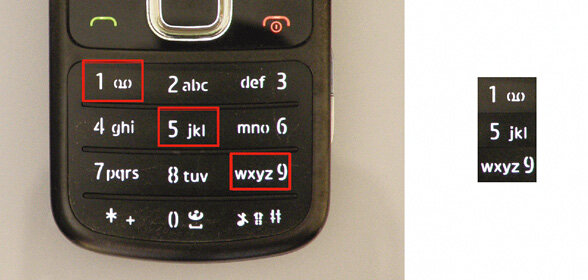

Podobnie prostym przypadkiem zadania wizyjnego jest analiza obrazów obiektów świecących światłem własnym, np. ocena kształtu piktogramu klawisza (widocznych na rys. 2), podświetlanego LED-em.

Łatwość powyższych zadań wynika z zagwarantowanego wysokiego kontrastu badanego obiektu w stosunku do tła i stabilnego poziomu jasności obiektu i tła.

Poziom trudności w zadaniu wizyjnym rośnie, gdy nie mamy wysokiego kontrastu obiektu w stosunku do tła lub kontrast ten jest niestabilny. Przypadek taki występuje zarówno gdy badany obiekt jak i tło tego obiektu oświetlone są tym samym oświetlaczem od strony kamery (front light).

Poziom trudności w zadaniu wizyjnym jest niski również przy użyciu linii laserowej jako oświetlacza. Gęstość energii lasera jest tak wysoka, że każde inne światło na obiekcie lub jego tle giną z obrazu po doregulowaniu przesłony obiektywu do jasności linii laserowej.

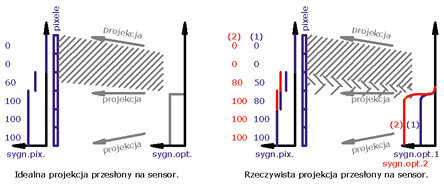

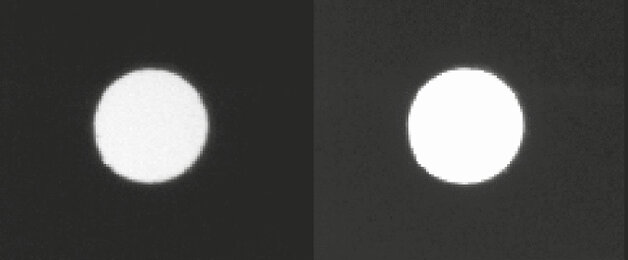

Ważną zasadą konstrukcji systemów wizyjnych jest „nieprześwietlanie obrazu”. W sensorach CCD prześwietlenie pikseli wywołuje efekty „blooming”

(przelewanie ładunków elektronów z prześwietlonych, jasnych pikseli sąsiednich ciemnych pikseli) i „smear” (przelewanie ładunków elektronów z mocno prześwietlonych pikseli na pionowy kanał transferu ładunków), które prowadzą do błędów w odwzorowaniu konturów na obrazie, a więc i do błędów pomiarów. Efekt „smear” może całkiem uniemożliwić pomiar. Sensory CCD powoli wypadają z rynku i zastępują je nowe sensory CMOS, ale zasada „nieprześwietlania obrazu” pozostaje w mocy. Efekt podobny do „bloomingu”, czyli przelewanie się jasnych obszarów obrazu na ciemne, powstaje w wyniku plamki obrazowej obiektywu. Idealny punkt obiektu nie jest odwzorowywany na sensorze kamery jako idealny punkt, a jako plamka o pewnej średnicy (kilku do kilkunastu um) i o rozkładzie podobnym do krzywej Gaussa. Gauss doświetla swoimi zboczami sąsiednie piksele.

Efekt prześwietlenia obrazu otworu przedstawiony jest na rysunku 5.

Inspekcja geometrii elementów przestrzennych często wymaga pomiarów trójwymiarowych. Za pomocą systemów wizyjnych można to robić na trzy sposoby:

− Projekcja światła strukturalnego – czyli projekcja systemu prążków na obiekt i z rejestracją obrazu każdego układu prążków.

Słabymi punktami tej techniki są: niska rozdzielczość projektorów prążków oraz małe moce źródeł światła projektorów. Zaletą jest szybki pomiar powierzchni 3D obiektów stacjonarnych. Technika ta będzie silnym impulsem rozwojowym po opracowaniu projektorów o wysokiej rozdzielczości i mocy.

− Skanowanie ze światłem strukturalnym – np. z linią laserową.

Na obiekt projektowana jest linia laserowa, a kamera obserwuje jej kształt na badanej powierzchni. Dzięki pewnemu kątowi pomiędzy osią lasera a osią kamery (zwykle 30–45°) w obrazie linii zakodowany jest wymiar „z”. Jest to bardzo stara technika geodezyjna: metoda triangulacyjna.

Wady tej techniki to: efekt plamek (specle) w obrazie linii laserowej, konieczność kontrolowanego ruchu kamery z laserem lub obiektu, uciążliwość spełnienia wymagań norm bezpieczeństwa w przypadku użycia laserów średniej i wyższej mocy, potrzebnej do szybkiego skanowania.

Zaletą tej techniki jest duża gęstość mocy lasera – linia laserowa jest bardzo dobrze widoczna nawet przy pracy w jasnym oświetleniu zewnętrznym.

− Metoda stereoskopowa, korzystająca z co najmniej dwóch kamer patrzących na obiekt pod różnymi kątami. Wymaga ona, aby obiekt miał pewne punkty charakterystyczne i fakturę powierzchni albo niezbędne jest znakowanie badanych powierzchni markerami. Obecnie technika ta jest mało popularna.

Technologie 3D to kompromis pomiędzy wielkością obszaru pomiarowego, dokładnością pomiaru i szybkością pomiaru. Dużo jest jeszcze do zrobienia. Przy spadających cenach kamer atrakcyjne cenowo staje się użycie wielu systemów 3D jednocześnie.

Inspekcja poprawności i kompletności wykonania

Kontrola poprawności lub kompletności wykonania to mieszanka kilku podstawowych zadań wizyjnych, jak kontrola wymiarów (np. wysokość łba śruby ponad płaszczyzną elementu mocowanego przez tę śrubę), dopasowanie wzorów (np. weryfikacja instalacji poprawnego rezystora lub odczyt kodu 2D z elementu), kontrola barwy lub odcienia szarości (np. sprawdzenie podłączenia właściwego przewodu).

Kontrola poprawności montażu jest bardzo popularna w motoryzacji i w produkcji urządzeń elektronicznych.

Stopień trudności zależy od stopnia trudności poszczególnych zadań elementarnych.

Kontrola poprawności i kompletności wykonania to tylko obszar zastosowań kilku podstawowych technik wizyjnych.

Inspekcja defektów powierzchni

To takie samo zadanie, jak inspekcja poprawności wykonania. Albo analizuje się różnicę barwy lub odcienia szarości piksela w stosunku do jego otoczenia i brak różnicy oznacza, że nie ma defektu, albo bada się kształt powierzchni techniką 3D w celu sprawdzenia, czy jest on zgodny jest z zapamiętanym wzorcem. Niezgodność oznacza odkształcenie powierzchni.

Kontrola defektów powierzchni to też tylko obszar zastosowań kilku podstawowych technik wizyjnych.

Pewną odmianą badania powierzchni jest kontrola nadruków (tekstów, symboli). Każdą literę, cyfrę lub inny znak można traktować jako blob, a odpowiedni algorytm wyliczy cechy znaku: pozycję środka ciężkości, obwód, powierzchnię, liczbę i powierzchnię dziur itd. Te parametry porównuje się z takimi samymi danymi dla znaków nadruku wzorcowego.

Kontrola nadruku to też tylko obszar zastosowań kilku podstawowych technik wizyjnych.

Inspekcja przemieszczeń i odkształceń

Wykorzystując dwa lub więcej kolejnych obrazów, zarejestrowanych w znanych momentach czasowych, analizując zmiany w obrazach obiektu (przesunięcie elementu, odkształcenie itp.) możemy zrealizować pomiary przemieszczeń, całego obiektu lub jego fragmentu.

Bardzo popularnym zadaniem tej grupy są testy zderzeniowe samochodów. Bardziej przemysłowe zadania to badanie szybkości ruchu elementów wykonawczych (rozłączniki, siłowniki, podajniki itp.) lub badanie deformacji powierzchni podczas obciążania lub zużycia.

Do badania przemieszczeń i odkształceń używa się podstawowych technik wizyjnych, jak szukanie krawędzi, analiza blobów, kojarzenie wzorów, techniki 3D.

|

Czym kierować się w wyborze systemu wizyjnego? Adam Kwiatkowski, Application Center Team Leader Festo Polska Wybierając system wizyjny, warto mieć świadomość, że słowo „system” nie jest w tym kontekście stosowane przypadkowo. System wizyjny oczywiście zawiera kamerę lub czujnik wizyjny, ale jest to tylko jeden z kilku niezbędnych elementów. Nie ma również dobrego systemu bez właściwie wyspecyfikowanego obiektywu. Z drugiej strony kamera i obiektyw przeważnie nie spełnią swojego zadania bez odpowiedniego światła i filtracji. A nawet już tak złożony zestaw może nie zdać egzaminu, jeśli nie zostanie odseparowany od zewnętrznych warunków oświetleniowych. Zacznijmy jednak od początku i skoncentrujmy nad samym wyborem kamery lub czujnika. Jakie parametry kamery należy brać pod uwagę? Co jest ważne i przydatne, a co stanowi jedynie dobrze opakowaną informację reklamową? Okazuje się, że najczęściej popełnianym błędem jest stosowanie kryterium liczby pikseli w kontekście wizyjnego systemu przemysłowego. A przecież kamera przemysłowa ma zupełnie inne przeznaczenie niż aparat cyfrowy domowego użytku – nie chodzi o to, by zdjęcie było ładne dla ludzkiego oka, tylko funkcjonalne dla dalszego procesu próbki i wnioskowania. Im większe zdjęcie, tym dłuższy czas analizy, a im dłuższy czas, tym mniejsza maksymalna częstotliwość kontroli, a rzadsza kontrola to mniejsza produkcja lub spadek jakości. System wizyjny należy zatem dobrać dokładnie do wymagania aplikacji – mówiąc potocznie: „uszyć go na miarę”. Dlatego też warto – na etapie doboru systemu wizyjnego – skorzystać z profesjonalnego wsparcia specjalistów. Jednym z miejsc, do których można się w tej sprawie udać jest Centrum Aplikacyjne spółki Festo. |

Pomiar barwy lub odcienia szarości

Producenci i sprzedawcy kamer deklarują: „kamera to nie urządzenie pomiarowe, a szczególnie nie do pomiaru barwy”. Mimo to próbuje się mierzyć barwy za pomocą kamer kolorowych.

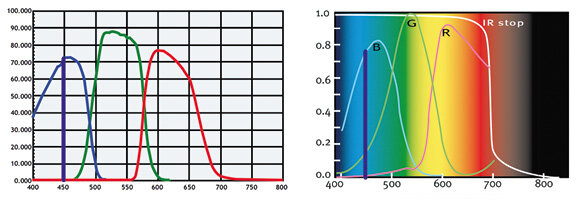

Kamera kolorowa wyposażona jest w filtry: albo w matrycę mikrofiltrów polimerowych RGB, przyklejoną do sensora monochromatycznego albo w pryzmaty dichroiczne rozdzielające widmo na trzy podzakresy R, G i B, skierowane na trzy oddzielne sensory monochromatyczne. Przeglądając specyfikację różnych kamer kolorowych, można dostrzec różne kształty charakterystyk absorpcji pikseli, wynikające z różnych charakterystyk transmisji filtrów. Jeśli dwie kamery o różnych charakterystykach widmowych zarejestrują obraz tego samego obiektu, przy tym samym oświetleniu, to sygnały wyjściowe pikseli R, G i B będą różne. Barwę zwykle ocenia się w skali CIELab (wylicza się ΔE) albo w skali HLS (ocenia się ΔH niezależne od jasności obiektu). Jeśli dane wejściowe, z dwóch różnych kamer, do wzorów na przeliczenia ze współrzędnych RGB na współrzędne CIELab lub HSL będą różne, to i wyniki wyliczeń punktów barwnych obiektu na układy CIELab lub HSL będą różne.

Przykładowo na rysunku 6 przedstawione są charakterystyki widmowe dwóch kamer, jednosensorowej i trójsensorowej. Jeśli kamery te będą obserwować niebieski obiekt o barwie odpowiadającej długości fali 450 nm i o wąskim widmie emisji to w kamerze trójsensorowej piksel niebieski odbierze sygnał maksymalny, a piksele zielony i czerwony odbiorą sygnał zerowy. W kamerze jednosensorowej piksel niebieski odbierze sygnał bliski maksymalnemu, piksel zielony odbierze sygnał około 15% maksimum, a piksel czerwony – sygnał bliski zeru. Przeliczenie takich trzech wartości R, G i B z obu kamer na układ współrzędnych CIELab lub HSL musi dać różne wyniki i doprowadzić do stwierdzenia, że kamery te obserwowały obiekty o różnych barwach. Wizyjny system oceny barwy popełni błąd.

Gdyby barwa obiektu uległa zmianie z 450 na 470 nm – na wyjściu kamery trójsensorowej prawie nie dostrzeżemy tej zmiany, a na wyjściu kamery jednosensorowej wzrosną sygnały pikseli niebieskich i zielonych. Czemu wzrosną sygnały zielonych pikseli, skoro obiekt jest niebieski? Bo w kamerze jednosensorowej filtry polimerowe mają bardzo szerokie charakterystyki transmisji (działają mało selektywnie).

Inny przykład: w kamerze trójsensorowej widmo 550 nm odebrałby tylko piksel zielony, a w kamerze jednosensorowej słabe sygnały odbiorą też piksele niebieski i czerwony.

|

Postęp technologiczny generuje nowe zastosowania Michal Aftewicz, Sales Manager Poland Stemmer Imaging W fabrykach obserwujemy wiele czujników i inteligentnych kamer do odczytywania kodów kreskowych, OCR i sprawdzania obecności. Nasza firma zajmuje się dostarczaniem komponentów i oprogramowania do budowy przemysłowych systemów wizyjnych dla integratorów i firm budujących maszyny, które w większości przypadków wykorzystywane są do bardziej złożonych zadań. Z reguły służą one do budowy aplikacji służącej kompleksowej kontroli jakości wytwarzanych produktów. Najczęściej takiemu monitoringowi poddaje się wymiary, kształty, ułożenie elementów na kontrolowanym detalu, kolor, czy też służy on do zliczania liczby produktów. Coraz częściej w użyciu pojawiają sie aplikacje bazujące na technologii 3D, które służą do sprawdzania orientacji przedmiotów w przestrzeni i sterowania robotami przemysłowymi w zautomatyzowanych gniazdach produkcyjnych. Obecnie systemy wizyjne można znaleźć już niemal w każdej branży – od samochodowej po spożywczą. W dzisiejszych czasach nikogo już nie dziwi kontrola produkcji ciastek czy gumy do żucia za pomocą tego typu rozwiązań. Coraz większą część rynku systemów wizyjnych zdobywają aplikacje służące kontroli ruchu i ochronie obiektów. Najczęściej w tego typu zastosowaniach wykorzystuje się automatyczne śledzenie obiektów, pomiar prędkości czy odczyt tablic rejestracyjnych pojazdów. |

Powyższe rozważania, dla ułatwienia zrozumienia, odnoszą się do wąskich zakresów (linii) widmowych. Jeśli dowolny, rzeczywisty rozkład widmowy badanej barwy podzielimy na wiele wąskich podzakresów widmowych, to reakcja kamery na każdy z tych podzakresów będzie taka sama, jak na opisane wyżej przykładowe zakresy 450, 470 i 550 nm. Efekt sumaryczny oceny barwy bardziej złożonej będzie sumą opisanych powyżej błędów elementarnych.

W literaturze i w Internecie można znaleźć wzory do przeliczania barw z układu RGB na CIELab lub HSL lub na inne układy współrzędnych barwnych. Nie ma tam jednak opisanych charakterystyk widmowych filtrów, dla których wzory te zostały opracowane. Współczynniki w tych wzorach mogą być różne dla różnych źródeł światła, ale nie ma żadnych warunków dla rozkładów widm absorpcji pikseli.

Nie ma „standardu” kamery (a właściwie filtrów), dla którego obowiązywałby zestaw wzorów przeliczeniowych z RGB na CIELab lub HSL. Dlatego właśnie kamera nie może służyć jako sensor miernika barwy.

Jeśli już trzeba mierzyć barwę na pewnym obszarze i nie jest możliwe użycie pomiaru punktowego za pomocą spektrofotometru, należy wybrać jedną z możliwości:

- kamerę mono i przed obiektywem umieścić karuzelę z filtrami,

- kamerę mono i przed obiektywem umieścić filtr przestrajalny,

- kamerę kolorową, a w polu widzenia umieścić klika wzorców barw, które umożliwią wyznaczenie poprawek na składowe R, G, B.

Można też zestaw wzorców wykorzystywać okresowo, do okresowej kalibracji kamery kolorowej, jeśli ufamy, że kamera jest stabilnym medium porównującym (jej parametry są stabilne) i mamy zaufanie do stabilności oświetlenia w czasie.

Użycie kamery kolorowej do pomiaru barwy, bez kalibracji, wzorcowania i wnikania w niuanse widmowe, jest też uprawnione, jeśli nie jest wymagana duża dokładność pomiaru barwy lub trzeba rozpoznać jedną z kilku bardzo różnych barw (np. barwę kabla lub LED-a).

Szacuję, że kamera kolorowa wykryje różnice ΔE na poziomie 3–5. Na pewno dokładność tę (np. wykrywalne ΔE) można poprawić, rejestrując kilka obrazów i wyliczając obraz średni. Szumy pikseli uśrednią się istotnie, zwiększając dokładność pomiaru ΔE.

Wykorzystanie kamery do pomiarów odcienia szarości lub jasności obiektu jest łatwiejsze niż do pomiarów barwy. Nie ma problemu przeliczania pomiędzy układami przestrzeni barwnych.

Pozostaje jednak problem nieliniowości charakterystyki widmowej sensora, nieliniowości charakterystyki piksela, stabilności tych charakterystyk, szumów sensora i najważniejszy: stabilności widmowej i czasowej oświetlenia (oświetlacza i światła otoczenia).

Jak w każdym urządzeniu pomiarowym, kalibracja jest bardzo pomocna, a przy dokładnych pomiarach niezbędna. Najprościej byłoby w polu widzenia umieścić mały wzorzec i analizować jego wygląd w każdym obrazie. Wzorzec może też być podkładany pod kamerę okresowo, jeśli ufamy w stabilność czasową kamery i oświetlenia.

Kontroli podlegają zarówno natężenie światła, jak i równomierność tego natężenia na całej powierzchni piktogramu.

|

Jak kalkulować opłacalność wdrożenia wizyjnego? Marcin Kowalski, AVICON Advanced Vision Control Systemy wizyjne mają bardzo zróżnicowane zastosowania, cechy oraz sposoby realizacji. Ogólną wytyczną, niezależnie od funkcji i stopnia skomplikowania zagadnienia wizyjnej kontroli, jest klasyczna kalkulacja opłacalności wdrożenia wizyjnego – porównanie kosztu oraz deklarowanego stopnia skuteczności do spodziewanych oszczędności związanych z wdrożeniem oraz okresu amortyzacji. Ponieważ kontrola wizyjna jest zazwyczaj kontrolą negatywną z odrzutem, często warto również rozważyć, czy nie da się najpierw udoskonalić samego procesu produkcyjnego kontrolowanego elementu. Należy przy tym zaznaczyć, iż kryterium najniższej ceny w przypadku integracji systemów wizyjnych może być bardzo mylące. Mimo coraz większego doświadczenia firm w tym zakresie, nadal zdarzają się przypadki zbyt pochopnego podejścia do procesu ofertowania z naciskiem na najniższą cenę i pominięciem dokładnych kalkulacji technicznych parametrów komponentów. Praktycznie każde wdrożenie ma charakter prototypowy i nie zawsze jest dostępna referencja integratora w podobnej aplikacji przemysłowej Z cech technicznych dobrego systemu wizyjnego można wymienić możliwość zdalnego serwisu przez połączenie VPN. Większość usterek w normalnym cyklu produkcyjnym nie jest zazwyczaj możliwa do znalezienia przez regularny personel utrzymania ruchu zakładu w sposób intuicyjny, a krótka, zdalna sesja diagnostyczna dostawcy potrafi zaoszczędzić dużo czasu spędzonego na samodzielnym szukaniu przyczyn nieprawidłowego działania. |

Pomiar temperatury

Wszyscy wiedzą, że „kamery podczerwone” mierzą temperaturę. Nie jest to jednak cała prawda. Kamery z sensorem czułym na podczerwień, najczęściej w zakresie widmowym 0,9–1,7 um, 2–5 um lub 8–14 um absorbują widmo emitowane przez badane obiekty. Wielkość emisji promieniowania zależy od temperatury obiektu, ale i od zdolności emisyjnej materiału (mocno zależnej od stanu powierzchni). Kamery podczerwone służące do pomiaru temperatury podlegają kalibracji u producenta na pewien zakres temperatury, np. „–20 °C do +120 °C” lub „+300 °C do +1200 °C”, przy założeniu pewnej typowej zdolności emisyjnej. Mimo iż szumy (DETD) kamer czułych na podczerwień mogą być bardzo niskie, na poziomie odpowiadającym zmianie temperatury około 10–20 mK, to producenci kamer (np. Xenics) deklarują dokładność pomiaru skalibrowanej fabrycznie kamery na ±1 °C do ±2 °C w całym zakresie pomiarowym. Zaskakujące? Można by oczekiwać lepszej dokładności, jak na tak zaawansowany sprzęt. Ta niezbyt wysoka dokładność pomiaru wynika z: niedokładności wzorca, niedokładności procesu kalibracji, niestabilności kamery w czasie i ze zmian temperatury otoczenia. Wymiana obiektywu wymaga ponownej kalibracji.

W zadaniach mało dokładnych, jak wykrywanie znaczących lokalnych zmian termicznych lub wykrywanie pozycji rozgrzanych elementów, dokładność ±2 °C wystarczy z zapasem.

W zadaniach medycznych, jak ocena zmian rany, dokładność ±2 °C to pomiar zgrubny, nieprzydatny do precyzyjnej kontroli skuteczności kuracji.

W dziedzinie dokładnych pomiarów temperatury za pomocą kamer jest jeszcze trochę do zrobienia.

Kamery czułe na podczerwień służą nie tylko do pomiarów temperatury. Znacznie popularniejszym zadaniem tych kamer jest wykrywanie miejsc o innej, zwykle podwyższonej temperaturze lub ocena pozycji lub kształtu obiektów o temperaturze wyższej niż temperatura ich tła, np. wykrywanie nadmiernie nagrzanych elementów modułu elektronicznego lub ocena poprawności rozmieszczenia przewodów grzejnych fotela samochodowego lub tylnej szyby samochodowej. Zadania te są dosyć proste w realizacji, gdyż kontrast badanego obiektu jest zwykle wysoki i stabilny. Są to standardowe zadania wizyjne, tyle że kamera jest droższa i ma zakres absorpcji inny niż ludzkie oko.

Podsumowanie

Systemy wizyjne znajdują coraz więcej zastosowań – w skanowaniu nadruków, w sortowaniu owoców lub produktów spożywczych, w prowadzeniu robotów itp. Należy się spodziewać, że z czasem rola inspektora jakości zostanie ograniczona do pracy w laboratorium, do kontroli produkcji prototypowej lub krótkoseryjnej, do opracowywania założeń dla wizyjnych systemów inspekcyjnych oraz do kalibracji i nadzoru nad systemami wizyjnymi.

źródło: Automatyka 5/2016

Komentarze

blog comments powered by Disqus